Что такое частота gpu

Тактовая частота графического процессора видеокарты

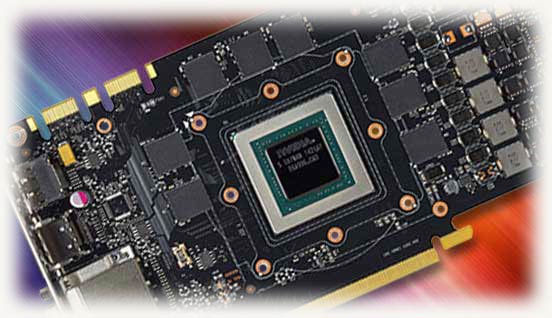

Графический процессор

Тактовая частота GPU

О графическом процессоре мы немного поговорили, теперь можем переходить к основной теме – тактовой частоте GPU.

Опять же, как и в центральных процессорах, чем выше частота, тем больше задач может выполнить процессор в единицу времени. Поэтому тактовая частота GPU напрямую влияет на производительность видеокарты.

У технически одинаковых графических процессоров увеличение частотных показателей приводит к пропорциональному росту результирующей производительности.

Если мы рассмотрим две топовые конкурентные модели от Nvidia и AMD, к примеру возьмём усреднённые показатели, таких девайсов, как видеокарта Asus Radeon HD7970 и Nvidia GTX 680, то мы увидим следующую картину:

Тут приведены средние показатели без конкретных моделей, просто для отображения общей тенденции. Так как мы хорошо знаем про неявно выраженную лидерскую позицию среди этих двух видеокарт, то можем с помощью этого немного порассуждать о влиянии частоты GPU на производительность.

Оценивая сугубо частотные показатели мы видим 925 и 1006 МГЦ в разнице частотных показателей, что довольно таки существенно. Учитывая примерно паритетные показатели производительности как у Radeon HD 7970, так и Nvidia GTX 680 – можно констатировать всю ту же зависимость от комплексности характеристик. То есть более низкая частота видеочипа у HD 7970 компенсируется другими характеристиками, которые раскроют видеокарту лучше, в определенных видах нагрузок. Поэтому при выборе видеокарты нужно подбирать модель по комплексу характеристик, а не только по одному объёму видеопамяти или частоте графического процессора.

Так что еще раз подчеркну, что комплексность параметров – превыше всего, главное не концентрироваться на чем-то одном.

На что влияет частота графического процессора в видеокарте и что это такое?

Привет, друзья! Как вы, вероятно, уже знаете, все видеокарты оборудованы GPU, то есть графическими процессорами. Одним из ключевых параметров при работе устройства, является частота графического процессора, на что влияет эта характеристика, я расскажу в сегодняшней публикации.

Зачем нужен графический процессор

Этот чип в видеокарте занят самым важным делом: он рендерит графику, просчитывая 2D и 3D объекты и их взаимодействие между собой и тем самым формируя изображение, передаваемое затем на дисплей монитора. Благодаря особенностям архитектуры, этот чип гораздо эффективнее обрабатывает графику по сравнению с центральным процессором, несмотря на меньшую мощность.

Такой чип может быть как составной частью видеокарты, так и быть интегрированным в северный мост материнской платы или как логический блок на ЦП. Как правило, последние два типа менее мощные и подходят для выполнения повседневных задач, но слабо справляются с рендерингом сложных объектов.

На что влияет его частота

Тактовая частота ядра – количество операций, которые графический процессор выполняет в секунду. На сегодняшний день у мощных видеокарт этот показатель уже перевалил за гигагерц.

Чем выше тактовая частота, тем больше данных может обработать графический ускоритель. Это влияет не только на количество FPS в играх, но и на количество примитивов в отрендеренных объектах, то есть на качество графики.

Таких показателей удалось добиться, благодаря уменьшению техпроцесса графического чипа, увеличив количество логических блоков на той же площади кристалла. Подробнее о техпроцессе видеокарты вы можете почитать здесь.

Даже в развитых странах не каждый геймер может позволить себе такое устройство.

Можно ли увеличить частоту и зачем это делать

Существует целый ряд программ, которые позволяют выполнить boost графического чипа, повысив его частотные характеристики (конечно, если компонент поддерживает такую опцию). Сюда можно отнести:

Кроме повышения частоты графического процессора, эти утилиты умеют увеличивать частоту памяти, регулировать скорость вращения кулеров и многое другое. «Что это дает в практическом плане?» — может спросить внимательный читатель.

Увеличение тактовой частоты, как можно догадаться, позволяет увеличить качество графики и количество ФПС в играх программными средствами, то есть не покупая новую видеокарту.

Такой «костыль» можно использовать как временное решение, когда юзер еще морально не созрел для покупки нового девайса, однако уже хочется поиграть в новинку, которую комп не вытягивает по системным требованиям.

При этом следует учитывать, что разгон видеокарты требует аккуратного и вдумчивого подхода – если переборщить с увеличением частоты и «дать копоти» больше, чем видеокарта реально сможет вытянуть физически, происходит перезапуск графического драйвера, что обычно ведет к крашу запущенной игры или видеоредактора.

Сломать девайс таким способом очень сложно, из-за предусмотренной программистами «защиты от дурака».Однако хочу также отметить, что особо настойчивые фанаты оверклокинга умудряются таки сжечь видеокарту, дав ей повышенную нагрузку и убрав количество оборотов кулера до минимума.

К сожалению, для майнинга такой продукт подходит хуже, чем аналогичная по цене видяха от AMD. Ну тут уже такое – или в игры гонять, или крипту майнить, не так ли?

До новых встреч на страницах моего блога, дорогие друзья! Не забудьте расшарить эту статью в социальных сетях и подписаться на новостную рассылку.

Интересные цифры. Как росла частота видеопроцессоров

Содержание

Содержание

История развития видеокарт не менее интересна, чем история процессоров. От первых видеокарт, с трудом рисующих 16 цветов, до сегодняшних «монстров» с гигабайтами памяти и частотой GPU под 2 ГГц. Давайте вспомним самые интересные видеокарты и то, как росла частота их GPU год за годом.

Первые видеокарты

Первые видеокарты, которые хотелось бы упомянуть, это CGA и MDA, появившиеся вместе с платформой IBM PC в начале 80-х годов. CGA, первый цветной видеоадаптер, умеющий рисовать 16 цветов, был построен на базе микросхемы Motorola MC6845.

Это был даже не видеопроцессор, в современном его понимании, и указать его тактовую частоту невозможно, но не упомянуть его нельзя — это основа и фундамент современных графических адаптеров.

Все 80-е годы шло довольно неторопливое их развитие с упором на повышение количества отображаемых цветов и увеличения разрешения. Следом за CGA появились EGA (1984 год), MCGA, 8514/A и VGA (1987 год), XGA (1990 год). Но до видеокарт, похожих на сегодняшние, было еще далеко и даже видеокарта S3 ViRGE, выпущенная в 1995 году, не имела указанной тактовой частоты видеопроцессора.

90-е годы

В 1996 году ATI Technologies выпускает ATI Rage II, созданную на переделанном чипе Mach64 GUI с частотой 60 МГц. 3Dfx выпускает легендарную Voodoo Graphics, с частотой чипа 50 МГц.

В 1997 году компания Nvidia выпускает знаменитую видеокарту RIVA 128, с ядром, работающим на частоте 100 МГц.

Год спустя компания S3 Graphics представила видеокарту Savage 3D, с частотой чипа 125 МГц.

В 1999 году 3Dfx выпускает Voodoo3, с частотой чипа 143 МГц.

2000-е годы

NVIDIA ответила видеокартой GeForce 3, с частотой чипа 200 Мгц. У GeForce 3 Ti 500 чип достигал частоты 240 МГц. По сегодняшним меркам эти частоты выглядят мизерными, чтобы оценить их, надо учитывать прирост в процентном соотношении.

В 2002 году NVIDIA выпускает GeForce 4 Ti 4600, на ядре NV25 с частотой 300 Мгц. В серии бюджетных видеокарт, GeForce 4 MX 460 тоже имела частоту в 300 МГц, но была существенно урезана по функционалу.

ATI не позволила GeForce 4 Ti 4600 долго сидеть на троне и Radeon 9700 PRO (325 МГц) стал самой быстрой видеокартой 2002 года. В 2003 году Radeon 9800 XT (412 МГц) не оставляет шанса новым GeForce FX.

В 2004 году выходят ATI Radeon X800 XT PE (520 МГц) и NVIDIA GeForce 6800 Ultra (400 МГц).

Этот период ознаменовался не только стремительным ростом частот, но и развитием графических процессоров «вширь»: увеличением пиксельных и вершинных конвееров, архитектурными новшествами, ростом частоты и ширины шины памяти. Все это вызвало резкое повышение энергопотребления и тепловыделения. TDP новых видеокарт перешагнул за 100 ватт и NVIDIA GeForce 6800 Ultra стал требовать минимум двухслотовую систему охлаждения и два разъема питания.

Годом позднее NVIDIA выпускает GeForce 7800 GTX (430 МГц) и двухчиповую 7950 GX2 (500 МГц).

В 2005 и 2006 годах ATI ответила видеокартами Radeon X1800 XT (625 Мгц) и Radeon X1900 XT (650 Мгц).

NVIDIA представила революционную видеокарту GeForce 8800 GTX на чипе G80. Ядро имело частоту 575 МГц, но частота шейдерных блоков в нем составляла целых 1350 МГц.

Архитектура оказалась настолько успешной, что выпускалась несколько лет, пережив два «ребрендинга».

В 2007 ATI представила Radeon HD2900 XT, созданную на базе чипа R600 с частотой 740 МГц. В том же году был представлен новый чип RV670, основанная на нем видеокарта Radeon HD 3870 имела частоту 775 Мгц. GeForce 9800 GTX+ от NVIDIA работала на частоте 738 МГц.

В 2008 году у NVIDIA выходит GeForce GTX 280 на чипе GT200 с частотой 602 МГц. ATI ответила видеоадаптером Radeon HD 4870 с частотой чипа 750 МГц. Radeon HD 4890, на той же архитектуре, имел внушительные 850 МГц по ядру.

В 2009 году успех ATI закрепил Radeon HD 5870 (850 МГц).

2010-е годы

В 2010 году выходит GeForce GTX 480 от NVIDIA, частота его чипа Fermi составляла 700 МГц.

Внимательный читатель наверняка уже заметил замедление и даже падение частот некоторых новинок. Видеокарты постепенно входят в фазу замедления роста частот. Как и процессоры после достижения частот выше 3 ГГц, так и видеокарты в те годы будут долго иметь частоту чипа в районе 1 ГГц.

AMD Radeon HD 6970 имеет частоту 880 Мгц. Обращу ваше внимание на то, что компания AMD купила ATI еще в 2006 году, но только с моделью Radeon HD 6970 ее видеокарты стали иметь «AMD», а не «ATI», в начале названия модели.

GeForce GTX 580 от NVIDIA имела частоту чипа 772 МГц. В конце 2011 года у AMD выходит Radeon HD 7970 с частотой чипа 925 МГц.

В 2012 году NVIDIA выпускает GeForce GTX 680 с базовой частотой чипа 1006 МГц. Гигагерц по ядру взят, но частота ядра отныне будет динамической и зависеть от нагрузки, потребления тока и температуры.

Теперь, чтобы оценить частоты на которых работает видеокарта, надо ориентироваться на среднюю поддерживаемую частоту в требовательных играх. И, желательно, на видеокарте с хорошим охлаждением.

AMD, в свою очередь, покоряет рубеж в 1 ГГц видеокартой Radeon HD 7970 GHz Edition.

Несмотря на то, что Radeon HD 7970 и GeForce GTX 680 выпущены 7 лет назад, они еще могут запускать новинки игр на низких настройках. Налицо замедление роста производительности GPU. Если сравнить отрезок в 7 лет до этого, 2005-2012 годы, к примеру, то различие в производительности намного выше.

GeForce GTX 780 на чипе GK110 от NVIDIA выходит в 2013 году и имеет базовую частоту 863 Мгц, частоту буста 900 МГц.

В 2013 году AMD выпускает Radeon R9 290X с частотой 800 МГц и частотой буста 1000 МГц. В 2015-м ее сменяет Radeon R9 390X с бустом до 1050 МГц.

У AMD в эти годы стоит еще отметить Radeon RX Vega 64 Liquid (1677 МГЦ) и Radeon VII (1750 МГц).

В наши годы даже частота буста уже не является показателем средних частот в играх. Модели видеокарт с заводским разгоном и с хорошим охлаждением показывают очень высокие частоты «из коробки». Например, Gigabyte GeForce GTX 1060 G1 Gaming автора «бустит» до 1926 МГц пока не прогреется.

Наше время

В реальных условиях их частоты переваливают за 2 ГГц, так что можно смело заявить, что в конце 2019 года планка 2 ГГц видеопроцессорами взята.

Чтобы удвоить частоту и пройти путь от GeForce GTX 680 до GeForce RTX 2080 SUPER потребовалось 7 лет. Интересно, сколько лет потребуется для взятия рубежа в 3 ГГц?

Руководство покупателя игровой видеокарты

Последнее обновление от 28.09.2012

Основные характеристики видеокарт

Современные графические процессоры содержат множество функциональных блоков, от количества и характеристик которых зависит и итоговая скорость рендеринга, влияющая на комфортность игры. По сравнительному количеству этих блоков в разных видеочипах можно примерно оценить, насколько быстр тот или иной GPU. Характеристик у видеочипов довольно много, в этом разделе мы рассмотрим лишь самые важные из них.

Тактовая частота видеочипа

Рабочая частота GPU обычно измеряется в мегагерцах, т. е. миллионах тактов в секунду. Эта характеристика прямо влияет на производительность видеочипа — чем она выше, тем больший объем работы GPU может выполнить в единицу времени, обработать большее количество вершин и пикселей. Пример из реальной жизни: частота видеочипа, установленного на плате Radeon HD 6670 равна 840 МГц, а точно такой же чип в модели Radeon HD 6570 работает на частоте в 650 МГц. Соответственно будут отличаться и все основные характеристики производительности. Но далеко не только рабочая частота чипа определяет производительность, на его скорость сильно влияет и сама графическая архитектура: устройство и количество исполнительных блоков, их характеристики и т. п.

В некоторых случаях тактовая частота отдельных блоков GPU отличается от частоты работы остального чипа. То есть, разные части GPU работают на разных частотах, и сделано это для увеличения эффективности, ведь некоторые блоки способны работать на повышенных частотах, а другие — нет. Такими GPU комплектуется большинство видеокарт GeForce от NVIDIA. Из свежих примеров приведём видеочип в модели GTX 580, большая часть которого работает на частоте 772 МГц, а универсальные вычислительные блоки чипа имеют повышенную вдвое частоту — 1544 МГц.

Скорость заполнения (филлрейт)

Скорость заполнения показывает, с какой скоростью видеочип способен отрисовывать пиксели. Различают два типа филлрейта: пиксельный (pixel fill rate) и текстурный (texel rate). Пиксельная скорость заполнения показывает скорость отрисовки пикселей на экране и зависит от рабочей частоты и количества блоков ROP (блоков операций растеризации и блендинга), а текстурная — это скорость выборки текстурных данных, которая зависит от частоты работы и количества текстурных блоков.

Например, пиковый пиксельный филлрейт у GeForce GTX 560 Ti равен 822 (частота чипа) × 32 (количество блоков ROP) = 26304 мегапикселей в секунду, а текстурный — 822 × 64 (кол-во блоков текстурирования) = 52608 мегатекселей/с. Упрощённо дело обстоит так — чем больше первое число — тем быстрее видеокарта может отрисовывать готовые пиксели, а чем больше второе — тем быстрее производится выборка текстурных данных.

Хотя важность «чистого» филлрейта в последнее время заметно снизилась, уступив скорости вычислений, эти параметры всё ещё остаются весьма важными, особенно для игр с несложной геометрией и сравнительно простыми пиксельными и вершинными вычислениями. Так что оба параметра остаются важными и для современных игр, но они должны быть сбалансированы. Поэтому количество блоков ROP в современных видеочипах обычно меньше количества текстурных блоков.

Количество вычислительных (шейдерных) блоков или процессоров

Пожалуй, сейчас эти блоки — главные части видеочипа. Они выполняют специальные программы, известные как шейдеры. Причём, если раньше пиксельные шейдеры выполняли блоки пиксельных шейдеров, а вершинные — вершинные блоки, то с некоторого времени графические архитектуры были унифицированы, и эти универсальные вычислительные блоки стали заниматься различными расчётами: вершинными, пиксельными, геометрическими и даже универсальными вычислениями.

Впервые унифицированная архитектура была применена в видеочипе игровой консоли Microsoft Xbox 360, этот графический процессор был разработан компанией ATI (впоследствии купленной AMD). А в видеочипах для персональных компьютеров унифицированные шейдерные блоки появились ещё в плате NVIDIA GeForce 8800. И с тех пор все новые видеочипы основаны на унифицированной архитектуре, которая имеет универсальный код для разных шейдерных программ (вершинных, пиксельных, геометрических и пр.), и соответствующие унифицированные процессоры могут выполнить любые программы.

По числу вычислительных блоков и их частоте можно сравнивать математическую производительность разных видеокарт. Большая часть игр сейчас ограничена производительностью исполнения пиксельных шейдеров, поэтому количество этих блоков весьма важно. К примеру, если одна модель видеокарты основана на GPU с 384 вычислительными процессорами в его составе, а другая из той же линейки имеет GPU с 192 вычислительными блоками, то при равной частоте вторая будет вдвое медленнее обрабатывать любой тип шейдеров, и в целом будет настолько же производительнее.

Хотя, исключительно на основании одного лишь количества вычислительных блоков делать однозначные выводы о производительности нельзя, обязательно нужно учесть и тактовую частоту и разную архитектуру блоков разных поколений и производителей чипов. Только по этим цифрам можно сравнивать чипы только в пределах одной линейки одного производителя: AMD или NVIDIA. В других же случаях нужно обращать внимание на тесты производительности в интересующих играх или приложениях.

Блоки текстурирования (TMU)

Эти блоки GPU работают совместно с вычислительными процессорами, ими осуществляется выборка и фильтрация текстурных и прочих данных, необходимых для построения сцены и универсальных вычислений. Число текстурных блоков в видеочипе определяет текстурную производительность — то есть скорость выборки текселей из текстур.

Хотя в последнее время больший упор делается на математические расчеты, а часть текстур заменяется процедурными, нагрузка на блоки TMU и сейчас довольно велика, так как кроме основных текстур, выборки необходимо делать и из карт нормалей и смещений, а также внеэкранных буферов рендеринга render target.

С учётом упора многих игр в том числе и в производительность блоков текстурирования, можно сказать, что количество блоков TMU и соответствующая высокая текстурная производительность также являются одними из важнейших параметров для видеочипов. Особенное влияние этот параметр оказывает на скорость рендеринга картинки при использовании анизотропной фильтрации, требующие дополнительных текстурных выборок, а также при сложных алгоритмах мягких теней и новомодных алгоритмах вроде Screen Space Ambient Occlusion.

Блоки операций растеризации (ROP)

Блоки растеризации осуществляют операции записи рассчитанных видеокартой пикселей в буферы и операции их смешивания (блендинга). Как мы уже отмечали выше, производительность блоков ROP влияет на филлрейт и это — одна из основных характеристик видеокарт всех времён. И хотя в последнее время её значение также несколько снизилось, всё ещё попадаются случаи, когда производительность приложений зависит от скорости и количества блоков ROP. Чаще всего это объясняется активным использованием фильтров постобработки и включенным антиалиасингом при высоких игровых настройках.

Ещё раз отметим, что современные видеочипы нельзя оценивать только числом разнообразных блоков и их частотой. Каждая серия GPU использует новую архитектуру, в которой исполнительные блоки сильно отличаются от старых, да и соотношение количества разных блоков может отличаться. Так, блоки ROP компании AMD в некоторых решениях могут выполнять за такт больше работы, чем блоки в решениях NVIDIA, и наоборот. То же самое касается и способностей текстурных блоков TMU — они разные в разных поколениях GPU разных производителей, и это нужно учитывать при сравнении.

Вплоть до последнего времени, количество блоков обработки геометрии было не особенно важным. Одного блока на GPU хватало для большинства задач, так как геометрия в играх была довольно простой и основным упором производительности были математические вычисления. Важность параллельной обработки геометрии и количества соответствующих блоков резко выросли при появлении в DirectX 11 поддержки тесселяции геометрии. Компания NVIDIA первой распараллелила обработку геометрических данных, когда в её чипах семейства GF1xx появилось по несколько соответстующих блоков. Затем, похожее решение выпустила и AMD (только в топовых решениях линейки Radeon HD 6700 на базе чипов Cayman).

В рамках этого материала мы не будем вдаваться в подробности, их можно прочитать в базовых материалах нашего сайта, посвященных DirectX 11-совместимым графическим процессорам. В данном случае для нас важно то, что количество блоков обработки геометрии очень сильно влияет на общую производительность в самых новых играх, использующих тесселяцию, вроде Metro 2033, HAWX 2 и Crysis 2 (с последними патчами). И при выборе современной игровой видеокарты очень важно обращать внимание и на геометрическую производительность.

Собственная память используется видеочипами для хранения необходимых данных: текстур, вершин, данных буферов и т. п. Казалось бы, что чем её больше — тем всегда лучше. Но не всё так просто, оценка мощности видеокарты по объему видеопамяти — это наиболее распространенная ошибка! Значение объёма видеопамяти неопытные пользователи переоценивают чаще всего, до сих пор используя именно его для сравнения разных моделей видеокарт. Оно и понятно — этот параметр указывается в списках характеристик готовых систем одним из первых, да и на коробках видеокарт его пишут крупным шрифтом. Поэтому неискушённому покупателю кажется, что раз памяти в два раза больше, то и скорость у такого решения должна быть в два раза выше. Реальность же от этого мифа отличается тем, что память бывает разных типов и характеристик, а рост производительности растёт лишь до определенного объёма, а после его достижения попросту останавливается.

Так, в каждой игре и при определённых настройках и игровых сценах есть некий объём видеопамяти, которого хватит для всех данных. И хоть ты 4 ГБ видеопамяти туда поставь — у неё не появится причин для ускорения рендеринга, скорость будут ограничивать исполнительные блоки, о которых речь шла выше, а памяти просто будет достаточно. Именно поэтому во многих случаях видеокарта с 1,5 ГБ видеопамяти работает с той же скоростью, что и карта с 3 ГБ (при прочих равных условиях).

Ситуации, когда больший объём памяти приводит к видимому увеличению производительности, существуют — это очень требовательные игры, особенно в сверхвысоких разрешениях и при максимальных настройках качества. Но такие случаи встречаются не всегда и объём памяти учитывать нужно, не забывая о том, что выше определённого объема производительность просто уже не вырастет. Есть у чипов памяти и более важные параметры, такие как ширина шины памяти и её рабочая частота. Эта тема настолько обширна, что подробнее о выборе объёма видеопамяти мы ещё остановимся в шестой части нашего материала.

Ширина шины памяти

Ширина шины памяти является важнейшей характеристикой, влияющей на пропускную способность памяти (ПСП). Большая ширина позволяет передавать большее количество информации из видеопамяти в GPU и обратно в единицу времени, что положительно влияет на производительность в большинстве случаев. Теоретически, по 256-битной шине можно передать в два раза больше данных за такт, чем по 128-битной. На практике разница в скорости рендеринга хоть и не достигает двух раз, но весьма близка к этому во многих случаях с упором в пропускную способность видеопамяти.

Современные игровые видеокарты используют разную ширину шины: от 64 до 384 бит (ранее были чипы и с 512-битной шиной), в зависимости от ценового диапазона и времени выпуска конкретной модели GPU. Для самых дешёвых видеокарт уровня low-end чаще всего используется 64 и реже 128 бит, для среднего уровня от 128 до 256 бит, ну а видеокарты из верхнего ценового диапазона используют шины от 256 до 384 бит шириной. Ширина шины уже не может расти чисто из-за физических ограничений — размер кристалла GPU недостаточен для разводки более чем 512-битной шины, и это обходится слишком дорого. Поэтому наращивание ПСП сейчас осуществляется при помощи использования новых типов памяти (см. далее).

Ещё одним параметром, влияющим на пропускную способность памяти, является её тактовая частота. А повышение ПСП часто напрямую влияет на производительность видеокарты в 3D-приложениях. Частота шины памяти на современных видеокартах бывает от 533(1066, с учётом удвоения) МГц до 1375(5500, с учётом учетверения) МГц, то есть, может отличаться более чем в пять раз! И так как ПСП зависит и от частоты памяти, и от ширины ее шины, то память с 256-битной шиной, работающая на частоте 800(3200) МГц, будет иметь бо́льшую пропускную способность по сравнению с памятью, работающей на 1000(4000) МГц со 128-битной шиной.

Особенное внимание на параметры ширины шины памяти, её типа и частоты работы следует уделять при покупке сравнительно недорогих видеокарт, на многие из которых ставят лишь 128-битные или даже 64-битные интерфейсы, что крайне негативно сказывается на их производительности. Вообще, покупка видеокарты с использованием 64-битной шины видеопамяти для игрового ПК нами не рекомендуется вовсе. Желательно отдать предпочтение хотя бы среднему уровню минимум со 128- или 192-битной шиной.

На современные видеокарты устанавливается сразу несколько различных типов памяти. Старую SDR-память с одинарной скоростью передачи уже нигде не встретишь, но и современные типы памяти DDR и GDDR имеют значительно отличающиеся характеристики. Различные типы DDR и GDDR позволяют передавать в два или четыре раза большее количество данных на той же тактовой частоте за единицу времени, и поэтому цифру рабочей частоты зачастую указывают удвоенной или учетверённой, умножая на 2 или 4. Так, если для DDR-памяти указана частота 1400 МГц, то эта память работает на физической частоте в 700 МГц, но указывают так называемую «эффективную» частоту, то есть ту, на которой должна работать SDR-память, чтобы обеспечить такую же пропускную способность. То же самое с GDDR5, но частоту тут даже учетверяют.

Основное преимущество новых типов памяти заключается в возможности работы на больших тактовых частотах, а соответственно — в увеличении пропускной способности по сравнению с предыдущими технологиями. Это достигается за счет увеличенных задержек, которые, впрочем, не так важны для видеокарт. Первой платой, использующей память DDR2, стала NVIDIA GeForce FX 5800 Ultra. С тех пор технологии графической памяти значительно продвинулись, был разработан стандарт GDDR3, который близок к спецификациям DDR2, с некоторыми изменениями специально для видеокарт.

GDDR3 — это специально предназначенная для видеокарт память, с теми же технологиями, что и DDR2, но с улучшенными характеристиками потребления и тепловыделения, что позволило создать микросхемы, работающие на более высоких тактовых частотах. Несмотря на то, что стандарт был разработан в компании ATI, первой видеокартой, её использующей, стала вторая модификация NVIDIA GeForce FX 5700 Ultra, а следующей стала GeForce 6800 Ultra.

GDDR4 — это дальнейшее развитие «графической» памяти, работающее почти в два раза быстрее, чем GDDR3. Основными отличиями GDDR4 от GDDR3, существенными для пользователей, являются в очередной раз повышенные рабочие частоты и сниженное энергопотребление. Технически, память GDDR4 не сильно отличается от GDDR3, это дальнейшее развитие тех же идей. Первыми видеокартами с чипами GDDR4 на борту стали ATI Radeon X1950 XTX, а у компании NVIDIA продукты на базе этого типа памяти не выходили вовсе. Преимущества новых микросхем памяти перед GDDR3 в том, что энергопотребление модулей может быть примерно на треть ниже. Это достигается за счет более низкого номинального напряжения для GDDR4.

Впрочем, GDDR4 не получила широкого распространения даже в решениях AMD. Начиная с GPU семейства RV7x0, контроллерами памяти видеокарт поддерживается новый тип памяти GDDR5, работающий на эффективной учетверённой частоте до 5,5 ГГц и выше (теоретически возможны частоты до 7 ГГц), что даёт пропускную способность до 176 ГБ/с с применением 256-битного интерфейса. Если для повышения ПСП у памяти GDDR3/GDDR4 приходилось использовать 512-битную шину, то переход на использование GDDR5 позволил увеличить производительность вдвое при меньших размерах кристаллов и меньшем потреблении энергии.

Видеопамять самых современных типов — это GDDR3 и GDDR5, она отличается от DDR некоторыми деталями и также работает с удвоенной/учетверённой передачей данных. В этих типах памяти применяются некоторые специальные технологии, позволяющие поднять частоту работы. Так, память GDDR2 обычно работает на более высоких частотах по сравнению с DDR, GDDR3 — на еще более высоких, а GDDR5 обеспечивает максимальную частоту и пропускную способность на данный момент. Но на недорогие модели до сих пор ставят «неграфическую» память DDR3 со значительно меньшей частотой, поэтому нужно выбирать видеокарту внимательнее.