Что такое полнота данных

Качество данных

80 % времени я трачу на очистку данных. Качественные данные всегда выигрывают у качественных моделей.

Томсон Нгуен

Данные – это фундамент, на котором держится компания с управлением на основе данных.

Если люди, принимающие решения, не располагают своевременной, релевантной и достоверной информацией, у них не остается другого выхода, как только положиться на собственную интуицию. Качество данных – ключевой аспект.

Специалистам‑аналитикам нужны правильные данные, собранные правильным образом и в правильной форме, в правильном месте, в правильное время. (Они просят совсем не много.) Если какое‑то из этих требований не выполнено или выполнено недостаточно хорошо, у аналитиков сужается круг вопросов, на которые они способны дать ответ, а также снижается качество выводов, которые они могут сделать на основании данных.

Как обеспечить правильность процесса сбора данных? С этой точки зрения качество данных выражается в их точности, своевременности, взаимосвязанности и так далее. Как убедиться, что мы собираем правильные данные? С этой точки зрения качество выражается в выборе оптимальных источников данных, чтобы обеспечить максимально эффективные выводы. Как правильно собирать данные? Как собирать правильные данные? Какие существуют способы определения достоверности данных? Когда данные могут оказаться ненадежными?

В статье будет рассмотрены критерии качества – все характеристики чистых данных; разные факторы, влияющие на ухудшение качества.

Активная проверка и сохранение качества данных – совместная обязанность всех сотрудников. Каждый участник аналитической цепочки ценности должен следить за качеством данных. Таким образом, каждому участнику будет полезно на более глубоком уровне разбираться в этом вопросе.

Аспекты качества данных

Качество данных невозможно свести к одной цифре. Качество – это не 5 или 32. Причина в том, что это понятие охватывает целый ряд аспектов, или направлений. Соответственно, начинают выделять уровни качества, при которых одни аспекты оказываются более серьезными, чем другие. Важность этих аспектов зависит от контекста анализа, который должен быть выполнен с этими данными. Например, если в базе данных с адресами клиентов везде указаны коды штатов, но иногда пропущены почтовые индексы, то отсутствие данных по почтовым индексам может стать серьезной проблемой, если вы планировали построить анализ на основе показателя почтового индекса, но никак не повлияет на анализ, если вы решили проводить его на уровне показателя по штатам.

Итак, качество данных определяется несколькими аспектами. Данные должны отвечать ряду требований.

Доступность

У аналитика должен быть доступ к данным. Это предполагает не только разрешение на их получение, но также наличие соответствующих инструментов, обеспечивающих возможность их использовать и анализировать. Например, в файле дампа памяти SQL (Structured Query Language – языка структурированных запросов при работе с базой данных) содержится информация, которая может потребоваться аналитику, но не в той форме, в которой он сможет ее использовать. Для работы с этими данными они должны быть представлены в работающей базе данных или в инструментах бизнес‑аналитики (подключенных к этой базе данных).

Точность

Данные должны отражать истинные значения или положение дел. Например, показания неправильно настроенного термометра, ошибка в дате рождения или устаревший адрес – это все примеры неточных данных.

Взаимосвязанность

Должна быть возможность точно связать одни данные с другими. Например, заказ клиента должен быть связан с информацией о нем самом, с товаром или товарами из заказа, с платежной информацией и информацией об адресе доставки. Этот набор данных обеспечивает полную картину заказа клиента. Взаимосвязь обеспечивается набором идентификационных кодов или ключей, связывающих воедино информацию из разных частей базы данных.

Полнота

Под неполными данными может подразумеваться как отсутствие части информации (например, в сведениях о клиенте не указано его имя), так и полное отсутствие единицы информации (например, в результате ошибки при сохранении в базу данных потерялась вся информация о клиенте).

Непротиворечивость

Данные должны быть согласованными. Например, адрес конкретного клиента в одной базе данных должен совпадать с адресом этого же клиента в другой базе. При наличии разногласий один из источников следует считать основным или вообще не использовать сомнительные данные до устранения причины разногласий.

Однозначность

Каждое поле, содержащее индивидуальные данные, имеет определенное, недвусмысленное значение. Четко названные поля в совокупности со словарем базы данных (подробнее об этом чуть позже) помогают обеспечить качество данных.

Релевантность

Данные зависят от характера анализа. Например, исторический экскурс по биржевым ценам Американской ассоциации землевладельцев может быть интересным, но при этом не иметь никакого отношения к анализу фьючерсных контрактов на грудинную свинину.

Надежность

Данные должны быть одновременно полными (то есть содержать все сведения, которые вы ожидали получить) и точными (то есть отражать достоверную информацию).

Своевременность

Между сбором данных и их доступностью для использования в аналитической работе всегда проходит время. На практике это означает, что аналитики получают данные как раз вовремя, чтобы завершить анализ к необходимому сроку. Недавно мне довелось узнать об одной крупной корпорации, у которой время ожидания при работе с хранилищем данных составляет до одного месяца. При такой задержке данные становятся практически бесполезными (при сохранении издержек на их хранение и обработку), их можно использовать только в целях долгосрочного стратегического планирования и прогнозирования.

Ошибка всего в одном из этих аспектов может привести к тому, что данные окажутся частично или полностью непригодными к использованию или, хуже того, будут казаться достоверными, но приведут к неправильным выводам.

Далее мы остановимся на процессах и проблемах, способных ухудшить качество данных, на некоторых подходах для определения и решения этих вопросов, а также поговорим о том, кто отвечает за качество данных.

ДАННЫЕ С ОШИБКАМИ

Ошибки могут появиться в данных по многим причинам и на любом этапе сбора информации. Давайте проследим весь жизненный цикл данных с момента их генерации и до момента анализа и посмотрим, как на каждом из этапов в данные могут закрадываться ошибки.

В данных всегда больше ошибок, чем кажется. По результатам одного из исследований, ежегодно американские компании терпят ущерб почти в 600 млн долл. из-за ошибочных данных или данных плохого качества (это 3,5 % ВВП!).

Во многих случаях аналитики лишены возможности контролировать сбор и первичную обработку данных. Обычно они бывают одним из последних звеньев в длинной цепочке по генерации данных, их фиксированию, передаче, обработке и объединению. Тем не менее важно понимать, какие проблемы с качеством данных могут возникнуть и как их потенциально можно разрешить.

Наиболее распространенные причины ошибок в данных:

Краткий обзор некоторых типов проблем с качеством данных и потенциальные варианты их решения:

Специалисты по аналитике должны активно участвовать в процессе сбора данных. Руководители направлений и эксперты в предметных областях должны проверить качество данных. Аналитики должны провести разведочный анализ или воспользоваться собственными методами определения, находятся ли значения в допустимых границах, соблюдаются ли ожидаемые закономерности (например, соотношение систолического и диастолического давления), оценить объем пропущенных данных и так далее.

Что такое полнота данных

Сегодня мы поговорим про качество данных – что это за показатель, в чем он измеряется и почему так важен для машинного обучения и других приложений Big Data. Читайте в нашей статье про процессы и инструменты управления качеством данных, а также профессию Data Quality инженера.

Почему большие данные должны быть качественными или что такое Data Quality

Большие данные полезны только когда из них можно извлечь ценные для бизнеса сведения – инсайты. Чтобы анализировать множество файлов или записей Big Data, эти информационные наборы должны обладать не только определенной структурой, но и отвечать следующим характеристикам [1]:

Аналитика больших данных для руководителей

Код курса

Ближайшая дата курса

Длительность обучения

24 ак.часов

Стоимость обучения

54 000 руб.

Совокупность количественных оценок каждого из этих показателей отражает качество данных (Data Quality) – характеристику, показывающую степень их пригодности к обработке и анализу, а также соответствие обязательным и специальным требованиям [1]. В упрощенном понимании качество данных – это степень их пригодности к использованию. В частности, стандарт ISO 9000:2015 именно так определяет качество данных по степени их удовлетворения требованиям: потребностям или ожиданиям, таким как полнота, достоверность, точность, последовательность, доступность и своевременность [2].

На практике оценка качества данных сильно зависит от контекста их использования. Например, для крупных маркетинговых кампаний может быть приемлемо до 3-5% дублированных или пропущенных записей, а в случае с медицинскими исследованиями такое недопустимо. Поэтому дисциплина интеллектуального анализа данных (Data Mining) выделяет целых 5 процедур подготовки информационных наборов к использованию в машинном обучении. Подробнее об этом мы рассказывали здесь. Однако, качество данных важно не только для точности алгоритмов Machine Learning. Устаревшие или ненадежные данные могут привести к дорогостоящим ошибкам, например, лишним расходам на закупку материалов из-за отсутствия актуальных сведений о складских запасах.

Как управлять качеством данных: процессы и инструменты

За оценку качества данных отвечают инженеры Data Quality, которые управляют информационными массивами, проверяют их поведение в текущих и новых условиях, контролируют релевантность, достаточность и актуальность. Как правило, обязанности Data Quality инженера не ограничиваются только рутинными проверками записей в таблицах СУБД, а требуют глубокого понимания бизнес-потребностей, чтобы трансформировать имеющиеся данные в пригодную к практическому использованию информацию. Для этого решаются следующие задачи: [3]:

Для организации data chain – цепочки проверочных тестов на каждой стадии обработки данных от источника до пункта финального использования могут использоваться легковесные SQL-запросы. Они помогают оценить отдельные атрибуты качества данных, например, tables metadata, blank lines, NULLs, Errors in syntax. Для регрессионного тестирования, когда используются уже готовые неизменяемые датасеты, код автотестов уже хранит готовые шаблоны проверки данных на соответствие качеству, такие как описания ожидаемых метаданных таблиц, строчных выборочных объектов для случайного выбора и т.д. Иногда в ходе тестирования Big Data Quality инженер пишет тестовые ETL-процессы с помощью Apache Spark или Airflow, используя уже готовые операторы, в частности, GCP BigQuery или создавая собственные [3]. Про операторы Apache Airflow мы писали здесь, на примере Kubernetes Operator.

Разумеется, все это инженеры Data Quality выполняют не вручную. Современный рынок ПО предлагает множество специализированных инструментов для проверки качества данных и их улучшения. В частности, Informatica Data Quality, Microsoft Data Quality Services, Oracle Enterprise Data Quality, SAP Data Services, Talend Open Studio for Data Quality и другие коммерческие продукты, а также открытые сервисы. Аналитическое агентство Gartner составило список ТОП-10 таких решений, проранжировав их по удобству использования, функциональным возможностям и отзывам профессионалов [4].

Как правило, большинство специализированных систем управления качеством данных автоматизируют следующие процессы Data Quality Management [2]:

Обеспечение качества данных не сводится лишь к технической задаче устранения дублирующихся или пропущенных значений. Важна также организационная сторона этого процесса, где задействован не только Data Quality инженер. В следующей статье мы поговорим про ответственность за качество данных и профессию дата стюарда (Data Steward). А о лучших практиках повышения Data Quality в компании Airbnb с помощью организационных изменений и архитектурно-технических решений читайте здесь.

Качество данных: от стратегии к практике

Качество данных: от стратегии к практике

Качество данных: от стратегии к практике

Ни большой объем данных, ни технологии искусственного интеллекта не принесут пользы компаниям, если они опираются на грязные данные. Для превращения сырых сведений в бизнес-активы требуется система управления качеством корпоративных данных.

Данные — топливо для систем искусственного интеллекта, сырье для аналитических алгоритмов и основа для систем автоматизации бизнес-процессов. Однако наивно ожидать, что данные изначально будут чистыми и пригодными для обработки, а если исходные данные некорректны, то и результаты будут соответствующими.

Что можно сделать для устранения дефектов в данных?

Как определить, что следует исправить, а что нет?

Как узнать, когда надо устранить проблему, а когда лучше ничего не трогать?

Иначе говоря: как управлять качеством данных?

Технологии искусственного интеллекта завораживают как представителей бизнеса, так и чиновников — многие компании и государственные учреждения стремятся использовать соответствующие инструменты при принятии решений, основываясь на имеющихся у них исторических и оперативных данных. Данные — ключевой фактор цифровой экономики, однако на деле успешных проектов оказывается много меньше, чем ожидается. Виной тому — низкое качество данных, беспорядок в которых не позволяет получить достоверные результаты от эксплуатации сложных и дорогих систем интеллектуальной автоматизации.

Качество данных: от стратегии к практике

Ни большой объем данных, ни технологии искусственного интеллекта не принесут пользы компаниям, если они опираются на грязные данные. Для превращения сырых сведений в бизнес-активы требуется система управления качеством корпоративных данных.

Дмитрий Волков, Алексей Незнанов

Данные — топливо для систем искусственного интеллекта, сырье для аналитических алгоритмов и основа для систем автоматизации бизнес-процессов. Однако наивно ожидать, что данные изначально будут чистыми и пригодными для обработки, а если исходные данные некорректны, то и результаты будут соответствующими.

Что можно сделать для устранения дефектов в данных?

Как определить, что следует исправить, а что нет?

Как узнать, когда надо устранить проблему, а когда лучше ничего не трогать?

Иначе говоря: как управлять качеством данных?

Технологии искусственного интеллекта завораживают как представителей бизнеса, так и чиновников — многие компании и государственные учреждения стремятся использовать соответствующие инструменты при принятии решений, основываясь на имеющихся у них исторических и оперативных данных. Данные — ключевой фактор цифровой экономики, однако на деле успешных проектов оказывается много меньше, чем ожидается. Виной тому — низкое качество данных, беспорядок в которых не позволяет получить достоверные результаты от эксплуатации сложных и дорогих систем интеллектуальной автоматизации.

Аналитики бьют тревогу: только 25% сотрудников компаний по всему миру готовы эффективно использовать данные в своей работе, а остальные сомневаются в своих способностях понимать данные (разбираться в первоисточниках, задавать вопросы, оценивать достоверность, ориентироваться в семантике данных и пр.). Как следствие, лишь чуть более трети сотрудников в той или иной степени доверяют собственным решениям, полученным только на основе данных, а более половины при принятии решений дополнительно консультируются с экспертами и надеются на собственную интуицию.

Переизбыток различных данных и изобилие разнообразных средств работы с ними могут ввести в заблуждение: может показаться, что для монетизации данных и повышения производительности сотрудников достаточно лишь инвестировать в передовые инструменты (машинное обучение, средства бизнес-аналитики и пр.), позволяющие, например, разработать индивидуальные привлекательные предложения за счет глубокого понимания рынка и потребителей. Но большие данные (3V: Variety, Velocity, Volume), которыми обладают компании, ничего не стоят без полноты и достоверности (Veracity).

Количество, скорость сбора и разнообразие сами по себе не гарантируют получения массива качественных данных, пригодных для работы. Мало того, как свидетельствуют многочисленные опросы, избыток данных вызывает у сотрудников стресс, а разнообразие информации, разрозненность ее источников и отсутствие стандартизации — это ключевые факторы, мешающие компаниям получать новые знания из данных.

| Рис. 1. Конвейер монетизации данных |

Конвейер на производстве позволил в свое время на порядок уменьшить время сборки автомобилей. Аналогичный конвейер (рис. 1) нужен и при работе с данными: он должен предусматривать автоматическую проверку качества всех «узлов» для их доставки на линию «сборки». Вполне логично предположить, что на этом конвейере работают множество специалистов: эксперты по качеству данных знают, где взять данные и как оценить их качество; инженеры по данным понимают, как получить данные, часто разбросанные по разным источникам, хранящиеся в разных форматах, поступающие с разной скоростью и в разных объемах; аналитики способны извлечь из данных полезную информацию; специалисты по исследованию данных (data scientist) могут обнаружить скрытые закономерности, подозрительные аномалии или логические связи в данных. Здесь нужны и другие специалисты по организации и поддержке «дата-проводов» (DataOps): коммуникаторы, юристы, сотрудники службы информационной безопасности.

Стратегия

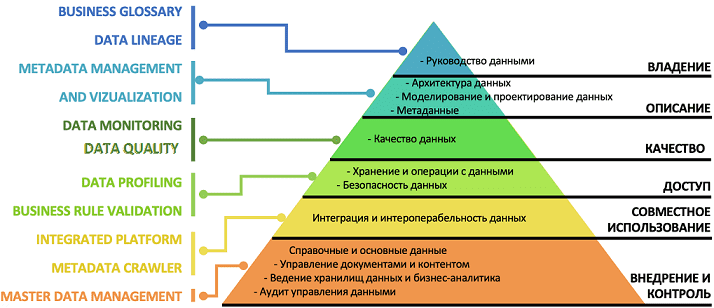

| Рис. 2. Место управления качеством данных в общем спектре работ с корпоративной информацией |

Как видно из рис. 2, деятельность по управлению качеством в общем объеме работ по управлению корпоративными данными выглядит достаточно скромно, однако если, например, в озере данных не окажется данных лишь от одного подразделения компании, то такое озеро вполне может стать «болотом», хотя вклад информации именно из этого подразделения может не превышать и 0,5% от общего объёма всех источников.

При разработке стратегии управления качеством данных следует прежде всего оринтироваться на цели бизнеса и текущие задачи организации, ответив на вопрос: зачем сейчас нужны данные?

Следует отметить, что стратегию нельзя «списать» у тех, кто этот путь уже прошел: она индивидуальна для каждой компании, а при ее разработке можно лишь руководствоваться общими рекомендациями.

Стратегия управления качеством данных строится с учетом следующих принципов : прозрачная и понятная модель показателей качества; институт владельцев и кураторов данных; явные приоритеты задач обработки данных; сбалансированность требований к качеству данных; информированность всех участников бизнес-процессов о качестве данных; максимальная автоматизация и воспроизводимость. Очевидно, что для выполнения всех этих принципов потребуется междисциплинарная многофункциональная команда, включающая руководителей информационных продуктов, экспертов по управлению данными и руководителей по направлениям продаж, маркетинга и операциям.

Стратегия управления качеством данных должна учитывать политику управления данными (Data Governance); предусматривать выполнение мероприятий по профилированию данных (Data Profiling), их сопоставлению и гармонизации (Data Matching); включать подготовку отчетов о качестве данных (Data Quality Reporting) и систему управления мастер-данными (Master Data Management, MDM); предусматривать средства интеграции данных, например о клиентах (Customer Data Integration, CDI); описывать интерфейсы к подсистемам управления информацией о продукте (Product Information Management, PIM) и управления цифровыми активами (Digital Asset Management, DAM). Любая серьезная организация или корпорация просто обязана иметь своего специалиста по настройке процессов управления данными и анализа их качества, причем с полномочиями на уровне топ-менеджера, отвечающего за принятие политик по управлению данными в целом.

Циклический конвейер управления качеством данных (рис. 3) может включать следующие процессы:

Профилирование данных заключается в сборе характеристик данных и их исследовании: необходимо оценить распределение величин, выбросы, параметры выборки, пропущенные значения, нарушение целостности, несоответствие бизнес-задаче и пр. Метрики непосредственно зависят от конкретной задачи. Потребитель данных формулирует требования к их качеству, например: доля бракованных записей, отклонение от целевого значения, отклонение от исторического среднего, базовое значение, агрегированное значение и пр. Контроль и мониторинг качества выполняет эксперт по качеству данных, в идеале в одном лице совмещающий три вида экспертизы (специалист по статистике, эксперт в конкретной предметной области, специалист по методологии анализа и обработки данных).

Сотрудников компании нужно мотивировать повышать качество данных, однако иногда по разным причинам им выгодно намеренно ухудшать качество данных. В какой-то степени обнаружить это помогает аудит качества, проводимый путем кросс-проверок и связывания данных с мастер-данными, причем аналитик, эксперт по качеству, владелец данных и их потребитель договариваются о процедурах контроля, что позволяет выработать согласованную позицию.

Очистка данных возможна далеко не всегда и определяется конкретным этапом управления качеством данных. Для первичных данных эффективны системы ввода с проверкой и контролем ошибок, а также двухэтапный аудит: сначала выборочный аудит отдельных записей, а потом аудит аудита. Так сейчас работают, например, агрегаторы клинических данных.

Хороший пример — Единая радиологическая информационная система (ЕРИС) с соответствующим контролем, предусматривающим аудит с проверкой протоколов и обучением персонала в первичном звене. Однако при очистке данных, возникающих дальше по цепочке, могут возникнуть проблемы: например, требуется обращение ко всем элементам данных, а значит, встает вопрос прав доступа к ним. Особенно сложна ситуация с персональными данными: не создано условий для официального использования защищенных хранилищ персональных данных для совместного использования несколькими организациями (даже на платформе ЕГАИС) и вероятность получить доступ к такому хранилищу для гармонизации персональных данных весьма мала.

В стратегии должен быть предусмотрен постоянный контроль за данными с целью отслеживания характеристик качества через определенные промежутки времени, однако часто это сложно и дорого, поэтому обычно чем-то пренебрегают — например, вводят понятие достаточности данных либо отдельно оценивают непротиворечивость наборов и корректность данных. При этом нередко используются выборочные проверки: в частности, если какая-то часть данных была введена вручную, то очевидно, что здесь могут быть ошибки. Если система ввода не позволяет допустить ошибки или автоматически их исправляет, то качество будет на порядок выше. Этим объясняется, например, большой разброс в качестве данных у различных медицинских информационных систем: в них по-разному организован ввод данных.

Базовые стандарты

Для исключения разночтений, при сборе простых характеристик нужной оценки качества данных применяются стандарты (начиная с ГОСТ 56215), регламентирующие понимание и применение терминов.

Стандарты группы ISO/TS 8000 и перевод (ГОСТ Р 56214-2014/ISO/TS 8000-1:2011 «Качество данных. Часть 1. Обзор» (docs.cntd.ru/document/1200114769)) — более 20 спецификаций, к которым сейчас активно добавляются новые:

a. части 1–99: «Качество общих данных»;

b. части 100–199: «Качество основных данных»;

c. части 200–299: «Качество данных в транзакциях»;

d. части 300–399: «Качество данных о продукции».

Принципы стандартов 8000:

качество применимо к данным, имеющим определенное назначение, учитывающимся при принятии какого-либо решения;

качество данных затрагивает нужные и подходящие данные, уместные в подходящем месте в подходящее время;

качество данных отвечает требованиям потребителя;

качество данных предотвращает повторение дефектов данных и сокращает избыточные расходы.

Международные стандарты группы ISO 25000 (iso25000.com) — это три главных стандарта: 25010, 25012 и 25040. Они определяют качество программного продукта с акцентом на общей модели качества данных, представленных в структурированном виде для информационной системы, а также критерии качества «продукта данных» как специального вида программного продукта.

Термины

Основные термины определяются, в частности, в ГОСТ Р ИСО 8000-2-2019 «Качество данных. Часть 2. Словарь».

Совокупность (набор данных, data set) — логически значимая группа данных.

Метаданные (metadata) — данные, определяющие и описывающие другие данные.

Качество данных (data quality) — степень, с которой набор характеристик, присущих данным, отвечает конкретным требованиям с точки зрения их применения. Неправильно выстроенные уровни качества данных непосредственно влияют на успех проекта: можно либо задать слишком высокий уровень и не достигнуть его, либо установить слишком низкий уровень и тогда будет потерян смысл системы аналитики.

Управление качеством данных (data quality management, DQM) — согласованная деятельность по контролю и управлению структурой, имеющей непосредственное отношение к качеству данных, обеспечение соответствия данных целям их использования с поддержанием полноты, точности, корректности и своевременности.

Верификация (verification) — подтверждение посредством представления объективных свидетельств того, что установленные требования выполнены.

Полнота и завершенность данных (data completeness) — качество всех имеющихся у пользователя данных, которыми он владеет на определенный момент. Полнота характеризует подтвержденную достаточность данных для достижения конкретной цели.

Авторитетный источник данных (authoritative data source) — владелец процесса, производящего данные.

Утвержденное эталонное значение (accepted reference value) — значение, применяемое в качестве согласованной ссылки при сравнении данных (реестр).

Истинное значение (true value) — значение параметров характеристики какого-либо объекта в определенных условиях.

Качество данных — комплексная характеристика, которую присваивают источникам или наборам данных для их сравнения и использования в конкретных целях. Нельзя говорить о качестве данных в отрыве от цели их использования — эта характеристика строится с учетом множества параметров, начиная от таких простых, как объем данных, и заканчивая такими сложными, как стилистика текста на естественном языке. При оценке качества важны следующие параметры: непротиворечивость — отсутствие ошибок, корректность и пригодность для достижения цели (процент ошибочно введенных данных, процент доказанных ошибок и пр.); актуальность — связанность данных с конкретным моментом времени (дата последнего обновления, средняя дата набора и пр.).

Для большинства типичных применений имеются готовые метрики — всевозможные сборки в одну оценку отдельных характеристик данных, а также популярные приложения для работы с конкретными наборами и источниками данных. Однако, когда итоговый рабочий набор собирается, например, из четырех, и при этом один взят из открытых источников, другой — стандартный справочник, третий — корпоративные данные, а четвертый — исторические данные о продажах, могут возникнуть проблемы. У всех источников разные характеристики качества, и при их взаимной гармонизации надо знать, как изменяются эти характеристики, что происходит при иерархическом выстраивании данных и когда имеются связи «многие ко многим», а также выявлять ошибки на верхних уровнях иерархии. Нельзя говорить, что при сборе наборов разного качества получится нечто среднее.

Инструменты

Для поддержки цикла обеспечения качества данных необходимы инструменты, помогающие сформировать единый взгляд на данные. Рынок средств управления качеством данных растет почти на 20% в год и к 2022 году составит 1,4 млрд долл. Причинами такого интереса являются увеличение объемов данных, рост количества источников, усиление регуляторного давления и рисков для репутации бренда.

Ключевые игроки рынка решений по управлению качеством данных: Ataccama, Alteryx, Experian, IBM, Informatica, Information Builders, Microsoft, Oracle, Pitney Bowes, SAP, SAS Institute, Syncsort, Talend, Trianz, Tamr, Tibco и Unidata. Инструментов, используемых для управления качеством данных, достаточно много, и условно их можно разделить на пять групп:

Классификация данных

С точки зрения управления первичные данные обычно делят на четыре класса:

Все качественные данные в конечном итоге должны становиться частью знаний (knowledge) с формально описанной семантикой (рис. 1), что и позволяет наиболее эффективно строить интеллектуальные системы, а не просто автоматизировать бизнес-процессы. Именно качество данных определяет качество интеллектуальных методов анализа данных.

Практика

В ряде корпораций хорошо себя зарекомендовал пользовательский портал для просмотра глоссария, визуализации траектории происхождения данных и мониторинга изменения правил оценки их качества. На основе таких сведений эксперт по качеству данных создает актуальное описание бизнес-правил (с помощью конструктора или языка программирования), опираясь на структуру таблиц корпоративного озера данных. Каждому бизнес-правилу присваиваются его измерение (метрика) и уровень критичности, а также указываются связанные роли. Создается реестр бизнес-правил с возможностью фильтрации и поиска, добавления атрибутов. Все бизнес-правила связываются с наборами данных в озере или хранилище.

По мере выполнения бизнес-процессов происходит профилирование полей наборов данных, позволяющее выявлять их типы и формат, обнаруживать некорректные и пустые значения, оценивать разброс значений и их частотное распределение, а также степень схожести с полями других таблиц по таким параметрам, как наименования, похожесть значений, похожесть типов, похожесть масок.

Наличие системы сертификации источников данных, возможность с помощью инструментов Data Governance обращаться к любому объекту из любого бизнес-приложения, подписка на изменения объектов и наборов данных, автоматическое обнаружение дублей и сквозные правила по качеству на уровне бизнес-показателей — все это в конечном итоге способствует повышению уровня доверия к данным из корпоративного озера. Следует отметить, что, вопреки бытующему мнению, для пользователей озера данных, как, собственно и для потребителей питьевой воды из озера обычного, прежде всего важно доверие к данным (чистоте и качеству воды), а не возможность получения красивых аналитических отчетов (пользование красивой кружкой).

Задача НСУД — обеспечить доверие граждан и бизнеса к государственным данным, для чего необходимы:

Естественно, ответ на запрос при работе с данными должен формироваться за разумные сроки и с учетом действующих нормативных оснований.

Цикл управления качеством государственных данных достаточно стандартный и напоминает общий (рис. 3), включая: построение (актуализацию) модели данных; определение и настройку правил контроля качества записей и массивов; контроль качества при обновлении данных в витринах для всех поставщиков; управление инцидентами качества; регулярный пересмотр модели и правил. Как и в проектах управления качеством данных для корпораций, при работе с государственными данными требуется определить ответственных — экспертов по качеству данных и инженеров по данным.

Профилирование позволяет сформировать пул «чистых» данных, в которых исключено дублирование (сдвоенные записи в базе) и пропущенные значения, выполнена очистка и нормализация (например, устранена множественность написания названий: «МИНПРОМТОРГ», «Минпромторг», «Министерство промышленности и торговли»).

Работая с таким пулом, цифровой инспектор может обнаружить, например, расхождение суммы по соглашению получателя субсидии с фактическими суммами по платежным поручениям. При этом работа ведется не со всем доступным массивом данных (открытые данные, сведения из внешних ФГИС, планы мероприятий, ведомственные базы и пр.), а лишь с заведомо подозрительными операциями.

Итак, управление качеством данных зависит от их применения, определяется критичностью и важностью наборов данных. Стратегию управления качеством нельзя заимствовать: для каждой компании и организации она своя. Однако имеются стандарты, инструменты и общие рекомендации по составу конвейера управления качеством и функциям его основных узлов.

Грязные данные способны похоронить любой проект, основанный на аналитике или технологиях искусственного интеллекта, независимо от того, применяются ли лучшие в индустрии алгоритмы, регулярно ли уточняются бизнес-правила или обучаются искусственные нейронные сети. Как правило, дешевле обеспечивать нужное качество данных, чем иметь дело с последствиями работы с дефектными данными.

Однако, несмотря на это, теме управления качеством данных до сих пор уделяется мало внимания, а монетизации данных часто мешают действующая бизнес-стратегия и отсутствие необходимых организационных структур работы с данными. Вместе с тем, как только бизнес поймет, что такое качественные данные, и с учетом этого знания построит свою бизнес-стратегию, сформируются и правильные структуры для их монетизации. Однако при этом следует учесть, что любая стратегия будет изначально обречена на провал, если в ней не предусмотрены мероприятия по формированию в организации культуры работы с данными.

Дмитрий Волков — старший научный сотрудник ИПМ им. М. В. Келдыша РАН,

Алексей Незнанов — старший научный сотрудник НИУ ВШЭ (Москва). Статья подготовлена на основе материалов выступления на конференции «Качество данных — 2020».

.jpg)

.jpg)

.jpg)