Что такое понятие информация

Значение слова «информация»

3. Сведения об окружающем мире и протекающих в нем процессах, воспринимаемые человеком или специальными устройствами. Поток информации.

[От лат. informatio — разъяснение, изложение]

Источник (печатная версия): Словарь русского языка: В 4-х т. / РАН, Ин-т лингвистич. исследований; Под ред. А. П. Евгеньевой. — 4-е изд., стер. — М.: Рус. яз.; Полиграфресурсы, 1999; (электронная версия): Фундаментальная электронная библиотека

Несмотря на широкую распространённость, понятие информации остаётся одним из самых дискуссионных в науке, а термин может иметь различные значения в разных отраслях человеческой деятельности.

Определений информации существует множество, причём академик Н. Н. Моисеев даже полагал, что в силу широты этого понятия нет и не может быть строгого и достаточно универсального определения информации. Тем не менее, в международных и российских стандартах существуют более или менее конкретные формулировки:

знания о предметах, фактах, идеях и т. д., которыми могут обмениваться люди в рамках конкретного контекста (ISO/IEC 10746-2:1996);

знания относительно фактов, событий, вещей, идей и понятий, которые в определённом контексте имеют конкретный смысл (ISO/IEC 2382:2015);

сведения, воспринимаемые человеком и (или) специальными устройствами как отражение фактов материального или духовного мира в процессе коммуникации (ГОСТ 7.0-99).

Хотя информация должна обрести некоторую форму представления (то есть превратиться в данные), чтобы ей можно было обмениваться, информация есть в первую очередь интерпретация (смысл) такого представления (ISO/IEC/IEEE 24765:2010). Поэтому в строгом смысле информация отличается от данных, хотя в неформальном контексте эти два термина очень часто используют как синонимы.

Первоначально «информация» — сведения, передаваемые людьми устным, письменным или другим способом (с помощью условных сигналов, технических средств и т. д.); с середины XX века термин «информация» превратился в общенаучное понятие, включающее обмен сведениями между людьми, человеком и автоматом, автоматом и автоматом; обмен сигналами в животном и растительном мире; передачу признаков от клетки к клетке, от организма к организму (например, генетическая информация); одно из основных понятий кибернетики.

ИНФОРМА’ЦИЯ, и, ж. (книжн., офиц.). 1. только ед. Действие по глаг. информировать. И. поставлена на должную высоту. 2. Сообщение, осведомляющее о положении дел или о чьей-н. деятельности, сведения о чем-н. Давать информацию. Газетная и. Неверная и.

Источник: «Толковый словарь русского языка» под редакцией Д. Н. Ушакова (1935-1940); (электронная версия): Фундаментальная электронная библиотека

информа́ция

1. сведения, знания, передаваемые, хранимые или получаемые системой, например человеком; то, что кто-либо сообщает или рассказывает; сообщения, новости ◆ Давать информацию. ◆ Газетная информация. ◆ Неверная информация. ◆ Информация — это различие, которое создаёт различие. Грегори Батесон

2. только ед. то же, что информирование; действие по значению гл. информировать ◆ Информация поставлена на должную высоту.

Фразеологизмы и устойчивые сочетания

Делаем Карту слов лучше вместе

Спасибо! Я обязательно научусь отличать широко распространённые слова от узкоспециальных.

Насколько понятно значение слова посмеяние (существительное):

Информация

Информа́ция (от лат. informatio — разъяснение, изложение)

первоначально — сведения, передаваемые одними людьми другим людям устным, письменным или каким-либо другим способом (например, с помощью условных сигналов, с использованием технических средств и т. д.), а также сам процесс передачи или получения этих сведений. И. всегда играла в жизни человечества очень важную роль. Однако в середины 20 в. в результате социального прогресса и бурного развития науки и техники роль И. неизмеримо возросла. Кроме того, происходит лавинообразное нарастание массы разнообразной И., получившее название «информационного взрыва». В связи с этим возникла потребность в научном подходе к И., выявлении её наиболее характерных свойств, что привело к двум принципиальным изменениям в трактовке понятия И. Во-первых, оно было расширено и включило обмен сведениями не только между человеком и человеком, но также между человеком и автоматом, автоматом и автоматом; обмен сигналами в животном и растительном мире. Передачу признаков от клетки к клетке и от организма к организму также стали рассматривать как передачу И. (см. Генетическая информация, Кибернетика биологическая). Во-вторых, была предложена количественная мера И. (работы К. Шеннона, А. Н. Колмогорова и др.), что привело к созданию информации теории (См. Информации теория).

Более общий, чем прежде, подход к понятию И., а также появление точной количественной меры И. пробудили огромный интерес к изучению И. С начала 1950-х гг. предпринимаются попытки использовать понятие И. (не имеющее пока единого определения) для объяснения и описания самых разнообразных явлений и процессов.

Исследование проблем, связанных с научным понятием И., идёт в трёх основных направлениях. Первое из них состоит в разработке математического аппарата, отражающего основные свойства И. (см. Информация в кибернетике).

Второе направление заключается в теоретической разработке различных аспектов И. на базе уже имеющихся математических средств, в исследовании различных свойств И. Например, уже с момента создания теории И. возникла сложная проблема измерения ценности, полезности И. с точки зрения её использования. В большинстве работ по теории И. это свойство не учитывается. Однако важность его несомненна. В количественной теории, выдвинутой в 1960 А. А. Харкевичем, ценность И. определяется как приращение вероятности достижения данной цели в результате использования данной И. Близкие по смыслу работы связаны с попытками дать строгое математическое определение количества семантической (т. е. смысловой) И. (Р. Карнап и др.).

Третье направление связано с использованием информационных методов в лингвистике, биологии, психологии, социологии, педагогике и др. В лингвистике, например, проводилось измерение информативной ёмкости языков. После статистической обработки большого числа текстов, выполненной с помощью ЭВМ, а также сопоставления длин переводов одного и того же текста на разные языки и многочисленных экспериментов по угадыванию букв текста выяснилось, что при равномерной нагрузке речевых единиц информацией тексты могли бы укоротиться в 4—5 раз. Так был с этой точки зрения установлен факт избыточности естественных языков и довольно точно измерена её величина, находящаяся в этих языках примерно на одном уровне. В нейрофизиологии информационные методы помогли лучше понять механизм действия основного закона психофизики — закона Вебера — Фехнера, который утверждает, что ощущение пропорционально логарифму возбуждения. Именно такая зависимость должна иметь место в случае, если нервные волокна, передающие сигналы от акцепторов к мозгу, обладают свойствами, присущими идеализированному каналу связи, фигурирующему в теории И. Значительную роль информационный подход сыграл в генетике и молекулярной биологии, позволив, в частности, глубже осознать роль молекул РНК как переносчиков И. Ведутся также исследования по применению информационных методов в искусствоведении.

Такое разнообразное использование понятия И. побудило некоторых учёных придать ему общенаучное значение. Основоположниками такого общего подхода к понятию И. были английский нейрофизиолог У. Р. Эшби и французский физик Л. Бриллюэн. Они исследовали вопросы общности понятия энтропии в теории И. и термодинамике, трактуя И. как отрицательную энтропию (негэнтропию). Бриллюэн и его последователи стали изучать информационные процессы под углом зрения второго начала термодинамики (См. Второе начало термодинамики), рассматривая передачу И. некоторой системе как усовершенствование этой системы, ведущее к уменьшению её энтропии. В некоторых философских работах был выдвинут тезис о том, что И. является одним из основных универсальных свойств материи. Положительная сторона этого подхода состоит в том, что он связывает понятие И. с понятием отражения. См. также ст. Информатика, Информация общественно-политическая, Массовая коммуникация.

Лит.: Эшби У. Р., Введение в кибернетику, пер. с англ., М., 1959; Харкевич А. А., О ценности информации, в сборнике: Проблемы кибернетики, в. 4, М., 1960; Шеннон К. Э., Работы по теории информации и кибернетике, пер. с англ., М., 1963; Колмогоров А. Н., Три подхода к определению понятия «количество информации», «Проблемы передачи информации», 1965, т. 1, в. 1; Бриллюэн Л., Научная неопределённость и информация, пер. с англ., М., 1966; Урсул А. Д., Информация, М., 1971.

общественно-политическая, совокупность сообщений об актуальных новостях внутренней и международной жизни, распространяемых средствами массовой коммуникации и ориентирующих аудиторию в фактах, явлениях, процессах политической, экономической, научной, культурной и пр. жизни общества. В социалистическом обществе к И. предъявляются требования правдивости и точности изложения правильно отобранных и сгруппированных типических фактов, объективного анализа и комментирования событий и процессов социальной жизни на основе марксистско-ленинской методологии в соответствии с принципом партийности. Коммунистическая партия придаёт важное значение проблеме информированности масс трудящихся с целью их сознательного и активного участия в общественной жизни, а также поступлению фактической и оценочной И. от самих трудящихся о положении дел во всех сферах народного хозяйства и культуры, о мнениях по различным общественным вопросам; эта «обратная» И. используется для принятия решений на различных уровнях социального управления.

Буржуазная пропаганда, стремясь ориентировать массы в своих целях, широко использует методы дезинформации (См. Дезинформация), необъективно излагая факты и сущность событий, замалчивая важные сведения, делая упор на сенсационные сообщения о малозначимых событиях.

В журналистике главными формами оперативной передачи И. являются информационные жанры публицистики (См. Публицистика) — хроника, заметки, репортажи, отчёты, интервью, обзоры.

Лит.: Бровиков В. И., Попович И. В., Современные проблемы политической информации и агитации, М., 1969.

в кибернетике. Естественнонаучное понимание И. основано на двух определениях этого понятия, предназначенных для различных целей (для информации теории (См. Информации теория), иначе называемой статистической теорией связи, и теории статистических оценок (См. Статистические оценки)). К ним можно присоединить и третье (находящееся в стадии изучения), связанное с понятием сложности алгоритмов.

Центральное положение понятия И. в кибернетике объясняется тем, что кибернетика (ограничивая и уточняя интуитивное представление об И.) изучает машины и живые организмы с точки зрения их способности воспринимать определённую И., сохранять её в «памяти», передавать по «каналам связи» и перерабатывать её в «сигналы», направляющие их деятельность в соответствующую сторону.

В некоторых случаях возможность сравнения различных групп данных по содержащейся в них И. столь же естественна, как возможность сравнения плоских фигур по их «площади»; независимо от способа измерения площадей можно сказать, что фигура A имеет не большую площадь, чем B, если A может быть целиком помещена в В (сравни примеры 1—3 ниже). Более глубокий факт — возможность выразить площадь числом и на этой основе сравнить между собой фигуры произвольной формы — является результатом развитой математической теории. Подобно этому, фундаментальным результатом теории И. является утверждение о том, что в определённых весьма широких условиях можно пренебречь качественными особенностями И. и выразить её количество числом. Только этим числом определяются возможности передачи И. по каналам связи и её хранения в запоминающих устройствах.

Пример 1. В классической механике знание положения и скорости частицы, движущейся в силовом поле, в данный момент времени даёт И. о её положении в любой будущий момент времени, притом полную в том смысле, что это положение может быть предсказано точно. Знание энергии частицы даёт И., но, очевидно, неполную.

Пример 2. Равенство a = b (1)

даёт И. относительно вещественных переменных a и b. Равенство

даёт меньшую И. [так как из (1) следует (2), но эти равенства не равносильны]. Наконец, равенство

равносильное (1), даёт ту же И., то есть (1) и (3) — это различные формы задания одной и той же И.

Пример 3. Результаты произведённых с ошибками независимых измерений какой-либо физической величины дают И. о её точном значении. Увеличение числа наблюдений увеличивает эту И.

Пример 3 а. Среднее арифметическое результатов наблюдений также содержит некоторую И. относительно рассматриваемой величины. Как показывает математическая статистика, в случае нормального распределения вероятностей ошибок с известной дисперсией среднее арифметическое содержит всю И.

Пример 4. Пусть результатом некоторого измерения является случайная величина X. При передаче по некоторому каналу связи X искажается, в результате чего на приёмном конце получают величину Y = X + θ, где θ не зависит от X (в смысле теории вероятностей). «Выход» Y даёт И. о «входе» X; причём естественно ожидать, что эта И. тем меньше, чем больше дисперсия случайной ошибки θ.

В каждом из приведённых примеров данные сравнивались по большей или меньшей полноте содержащейся в них И. В примерах 1—3 смысл такого сравнения ясен и сводится к анализу равносильности или неравносильности некоторых соотношений. В примерах 3 а и 4 этот смысл требует уточнения. Это уточнение даётся, соответственно, математической статистикой и теорией И. (для которых эти примеры являются типичными).

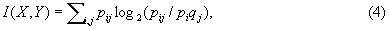

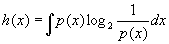

В основе теории информации лежит предложенный в 1948 американским учёным К. Шенноном способ измерения количества И., содержащейся в одном случайном объекте (событии, величине, функции и т. п.) относительно другого случайного объекта. Этот способ приводит к выражению количества И. числом. Положение можно лучше объяснить в простейшей обстановке, когда рассматриваемые случайные объекты являются случайными величинами, принимающими лишь конечное число значений. Пусть X — случайная величина, принимающая значения x1, x2. xn с вероятностями p1, p2. pn, а Y — случайная величина, принимающая значения y1, y2. ym с вероятностями q1, q2. qm. Тогда И. I (X,Y) относительно Y, содержащаяся в X, определяется формулой

где pij — вероятность совмещения событий X = xi и Y = yj и логарифмы берутся по основанию 2. И. I (X, Y) обладает рядом свойств, которые естественно требовать от меры количества И. Так, всегда I (X, Y) ≥ 0 и равенство I (X, Y) = 0 возможно тогда и только тогда, когда pij = piqj при всех i и j, т. е. когда случайные величины X и Y независимы. Далее, всегда I (X, Y) ≤ I (Y, Y) и равенство возможно только в случае, когда Y есть функция от X (например, Y = X 2 и т. д.). Кроме того, имеет место равенство I (X, Y) = I (Y, X).

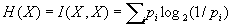

Величина

носит название энтропии случайной величины X. Понятие энтропии относится к числу основных понятий теории И. Количество И. и энтропия связаны соотношением

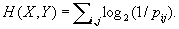

Величина энтропии указывает среднее число двоичных знаков (см. Двоичные единицы), необходимое для различения (или записи) возможных значений случайной величины (подробнее см. Кодирование, Энтропия). Это обстоятельство позволяет понять роль количества И. (4) при «хранении» И. в запоминающих устройствах. Если случайные величины X и Y независимы, то для записи значения X требуется в среднем H (X) двоичных знаков, для значения Y требуется H (Y) двоичных знаков, а для пары (X, Y) требуется Н (Х) + H (Y) двоичных знаков. Если же случайные величины X и Y зависимы, то среднее число двоичных знаков, необходимое для записи пары (X, Y), оказывается меньшим суммы Н (Х) + H (Y), так как

С помощью значительно более глубоких теорем выясняется роль количества И. (4) в вопросах передачи И. по каналам связи. Основная информационная характеристика каналов, так называемая пропускная способность (или ёмкость), определяется через понятие «И.» (подробнее см. Канал).

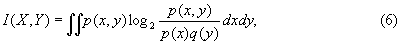

где буквами р и q обозначены плотности вероятности Х и Y соответственно. При этом энтропии Н (X) и Н (Y) не существуют, но имеет место формула, аналогичная (5),

дифференциальная энтропия X [h (Y) и h (X, Y) определяется подобным же образом].

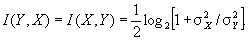

Пример 5. Пусть в условиях примера 4 случайные величины X и θ имеют нормальное распределение вероятностей с нулевыми средними значениями и дисперсиями, равными соответственно σ 2 х и σ 2 θ. Тогда, как можно подсчитать по формулам (6) или (7):

Таким образом, количество И. в «принятом сигнале» Y относительно «переданного сигнала» X стремится к нулю при возрастании уровня «помех» θ (т. е. при σ 2 θ → ∞) и неограниченно возрастает при исчезающе малом влиянии «помех» (т. е. при σ 2 θ → 0).

Особенный интерес для теории связи представляет случай, когда в обстановке примеров 4 и 5 случайные величины X и Y заменяются случайными функциями (или, как говорят, случайными процессами) X (t) и Y (t), которые описывают изменение некоторой величины на входе и на выходе передающего устройства. Количество И. в Y (t) относительно X (t) при заданном уровне помех («шумов», по акустической терминологии) θ(t) может служить критерием качества самого этого устройства (см. Сигнал, Шеннона теорема).

В задачах математической статистики также пользуются понятием И. (сравни примеры 3 и 3а). Однако как по своему формальному определению, так и по своему назначению оно отличается от вышеприведённого (из теории И.). Статистика имеет дело с большим числом результатов наблюдений и заменяет обычно их полное перечисление указанием некоторых сводных характеристик. Иногда при такой замене происходит потеря И., но при некоторых условиях сводные характеристики содержат всю И., содержащуюся в полных данных (разъяснение смысла этого высказывания даётся в конце примера 6). Понятие И. в статистике было введено английским статистиком Р. Фишером в 1921.

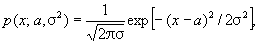

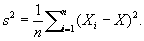

где параметры a и σ 2 (среднее и дисперсия) неизвестны и должны быть оценены по результатам наблюдений. Достаточными статистиками (т. е. функциями от результатов наблюдении, содержащими всю И. о неизвестных параметрах) в этом примере являются среднее арифметическое

и так называемая эмпирическая дисперсия

Если параметр σ 2 известен, то достаточной статистикой будет только X (сравни пример 3 а выше).

Смысл выражения «вся И.» может быть пояснён следующим образом. Пусть имеется какая-либо функция неизвестных параметров φ = φ (a, σ 2 ) и пусть

Лит.: Крамер Г., Математические методы статистики, пер. с англ., М., 1948; Ван-дер-Варден Б. Л., Математическая статистика, пер. с нем., М., 1960; Кульбак С., Теория информации и статистика, пер. с англ., М., 1967.

Значения в других словарях

Что такое информация — понятие, виды и свойства информации, ее передача, обработка и хранение

Здравствуйте, уважаемые читатели блога KtoNaNovenkogo.ru. Один из богатейших людей в истории человечества Натан Ротшильд утверждал — кто владеет информацией, тот владеет миром.

Что же это за штука такая, с помощью которой можно сколотить миллиардное состояние и управлять чужими судьбами?

Понятие информации — что это

Термин образовался от латинского слова informatio, что переводится как «разъяснение, представление, понятие». Есть и другое слово на латыни — informare, которое означает «мыслить, создавать форму, обучать, представлять».

Информация — это любые сведения, которые воспринимаются живыми организмами, электронными устройствами и другими системами, об окружающем мире, процессах, предметах и явлениях.

Сведения — это знания, передаваемые в виде сообщений, уведомлений и сигналов.

Информационное сообщение — это совокупность элементов информации, объединенных внутренними связями.

Вот газета пишет, что российская экономика испытывает небывалый рост. Или коллега по секрету говорит, что скоро урежут зарплаты. Все это информационные сообщения.

При этом одно и то же сообщение может содержать разное количество информации в зависимости от того, кто его получатель. Например, нам присылают сообщение: 明天该公司的股票将翻倍. Если мы не знаем языка, на котором написано послание, для нас нет никакой информации. А вот игрок на фондовой бирже из Китая сразу поймет — здесь сказано, что завтра акции некой компании удвоятся в цене.

В разных сферах деятельности понятие информации характеризуется при помощи специфических признаков. Например, в области компьютерной техники термин имеет следующее определение:

«информация — это набор символов и знаков, который имеет смысл и понятен для компьютера».

Такая информация может выглядеть как последовательность нулей и единиц: 00010001110001100011.

Виды информации

Это позволяет разным культурам взаимодействовать между собой, делиться опытом. С изобретением письменности у человечества появилась возможность не держать в памяти огромные массивы информации, передавая ее из уст в уста, из поколения в поколение.

Теперь можно записать все на бумаге и быть спокойным, что ничего не пропадет и не забудется. Прямо сейчас вы читаете эту статью, а ваш мозг поглощает текстовую информацию.

Наука до сих пор не нашла способов кодировать и передавать такую информацию. Иначе можно было бы испытать чужие ощущения от похода в ресторан.

Свойства информации

Недостоверная информация возникает в результате преднамеренного искажения действительности — дезинформации.

Пример дезинформации содержится в известном анекдоте.

Мать пишет сыну в тюрьму: «Тебя посадили, некому даже огород вскопать. А у меня совсем нет сил». Сын отвечает: «Мама, ничего не трогай! Раскопаешь такое, что мне срок добавят». Следующее письмо от матери: «Приезжали полицейские, все перерыли. Ничего не нашли, уехали очень злые». Сын пишет: «Дорогая мама, чем мог — помог. Картошку сажай сама».

Другая причина недостоверности — случайное искажение. Многие в детстве играли в испорченный телефон: Вася сказал Пете, Петя — Сереже, Сережа — Мише. В итоге изначальное сообщение изменилось на прямо противоположное.

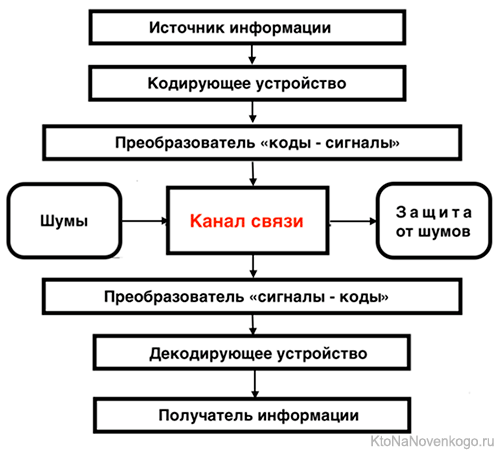

Модель передачи информации

Передача данных – это физический перенос информации в форме сигналов от одной точки к другой по каналу связи с целью последующей обработки.

Чтобы информация приносила пользу, она должна передаваться и приниматься. Это происходит по следующей схеме:

Модель была описана американским математиком и инженером Клодом Шенноном в статье «Математическая теория связи».

Рассмотрим на примере: нужно позвонить приятелю и пригласить его на день рождения. Источник информации (это вы) — объект, который создает передаваемое сообщение. Вы говорите: «Вася, приходи ко мне на день рождения!». Микрофон в трубке телефона улавливает звуковые колебания и преобразует их в электрические сигналы.

Эти сигналы направляются к Васе по каналу связи. А там информационное сообщение подвергается внешним воздействиям — шумам и помехам, что может приводить к искажениям. Вася не понимает: «Куда, куда мне идти? Повтори, не слышу, все шипит».

Чем выше уровень помех, тем сложнее передать сигнал. Для защиты информационного сигнала от внешних воздействий используют различные меры:

На стороне другого абонента происходит обратный процесс – полученные электрические сигналы преобразуются в звуковые волны. Они вылетают из динамика телефона и попадают прямо в Васино ухо.

Обработка и хранение информации

Наша эпоха характеризуется уникальным явлением, которое называется «информационным взрывом». Происходит резкий рост объема информации в масштабах планеты.

Информационный поток увеличивается на 30% каждый год, вовлекая в свои процессы даже маленьких детей, которые чуть ли не с рождения пользуются телефонами и планшетами.

Информация со временем накапливается. Человеческое сознание уже не способно обрабатывать такие объемы. Тут на помощь приходят компьютеры, которые берут на себя функции по обработке и хранению сведений.

Обработка – это процесс, при котором изменяется содержание или форма представления информации.

Например, режиссер берет готовый сценарий и снимает фильм. Он меняет форму – с текстовой на визуальную.

Хранение информации – это ее запись на запоминающие устройства для последующей обработки.

Раньше для этих целей использовались дискеты и перфокарты. Теперь же применяют лазерные диски (CD и DVD) и энергонезависимую память.

Удачи вам! До скорых встреч на страницах блога KtoNaNovenkogo.ru

Эта статья относится к рубрикам:

Комментарии и отзывы (2)

Сейчас много лживой информации, но проверить достоверность всё же можно, просто нужно перепроверить её в нескольких источниках, а ещё лучше найти первоисточник, если информация появляется из ниоткуда, значит это фейк. Сейчас за распространение фейков введена ответственность, но тут тоже тонкая грань между желанием оградить общество от недостоверной информации и затыканием рта несогласным.

Как показывает практика, даже имея под рукой интернет, и неограниченный доступ к любой информации, человек этой возможностью не пользуется. Та информация, которая ему неприятна, или вступает в конфликт с его устоявшимися убеждениями, будет игнорироваться.

Впрочем, уж лучше так, чем вовсе не иметь доступ к источникам информации. Да и вообще, сейчас полезная информация тонет в потоках спама и манипуляций.