дата модели что это

6) Что такое моделирование данных?

Что такое моделирование данных?

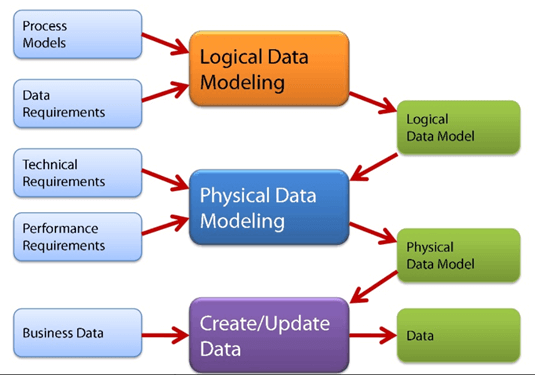

Моделирование данных (моделирование данных) — это процесс создания модели данных для хранения данных в базе данных. Эта модель данных представляет собой концептуальное представление объектов данных, связей между различными объектами данных и правилами. Моделирование данных помогает визуально представлять данные и обеспечивает соблюдение бизнес-правил, нормативных требований и государственных политик в отношении данных. Модели данных обеспечивают согласованность в соглашениях об именах, значениях по умолчанию, семантике, безопасности при обеспечении качества данных.

Модель данных подчеркивает, какие данные необходимы и как они должны быть организованы, а не какие операции должны выполняться с данными. Модель данных похожа на план здания архитектора, который помогает построить концептуальную модель и установить отношения между элементами данных.

Два типа методов моделей данных:

Мы обсудим их подробно позже.

В этом уроке вы узнаете больше о

Зачем использовать модель данных?

Основная цель использования модели данных:

Типы моделей данных

Существует в основном три различных типа моделей данных:

Концептуальная модель

Основная цель этой модели — установить сущности, их атрибуты и их взаимосвязи. На этом уровне моделирования данных едва ли есть какая-либо подробная информация о фактической структуре базы данных.

3 основных арендатора модели данных

Entity : реальная вещь

Атрибут : характеристики или свойства объекта

Большой гид по Data Science для начинающих: термины, применение, образование и вход в профессию

Наши друзья из «Цеха» опубликовали пошаговую инструкцию для начинающих в сфере Data Science от Елены Герасимовой, руководителя направления «Аналитика и Data Science» в Нетологии. Делимся с вами.

О чём речь

Data Science — деятельность, связанная с анализом данных и поиском лучших решений на их основе. Раньше подобными задачами занимались специалисты по математике и статистике. Затем на помощь пришел искусственный интеллект, что позволило включить в методы анализа оптимизацию и информатику. Этот новый подход оказался намного эффективнее.

Как строится процесс? Всё начинается со сбора больших массивов структурированных и неструктурированных данных и их преобразования в удобный для восприятия формат. Дальше используется визуализация, работа со статистикой и аналитические методы — машинного и глубокого обучения, вероятностный анализ и прогнозные модели, нейронные сети и их применение для решения актуальных задач.

Пять главных терминов, которые нужно запомнить

Искусственный интеллект, машинное обучение, глубокое обучение и наука о данных — основные и самые популярные термины. Они близки, но не эквивалентны друг другу. На старте важно разобраться, чем они отличаются.

Искусственный интеллект (Artificial Intelligence) — область, посвящённая созданию интеллектуальных систем, работающих и действующих как люди. Её возникновение связано с появлением машин Алана Тьюринга в 1936 году. Несмотря на долгую историю развития, искусственный интеллект пока не способен полностью заменить человека в большинстве областей. А конкуренция ИИ с людьми в шахматах и шифрование данных — две стороны одной медали.

Машинное обучение (Machine learning) — создание инструмента для извлечения знаний из данных. Модели ML обучаются на данных самостоятельно или поэтапно: обучение с учителем на подготовленных человеком данных и без учителя — работа со стихийными, зашумленными данными.

Глубокое обучение (Deep learning) — создание многослойных нейронных сетей в областях, где требуется более продвинутый или быстрый анализ и традиционное машинное обучение не справляется. «Глубина» обеспечивается некоторым количеством скрытых слоев нейронов в сети, которые проводят математические вычисления.

Большие данные (Big Data) — работа с большим объёмом часто неструктурированных данных. Специфика сферы — это инструменты и системы, способные выдерживать высокие нагрузки.

Наука об анализе данных (Data Science) — в основе области лежит наделение смыслом массивов данных, визуализация, сбор идей и принятие решений на основе этих данных. Специалисты по анализу данных используют некоторые методы машинного обучения и Big Data: облачные вычисления, инструменты для создания виртуальной среды разработки и многое другое.

Где применяется Data Science

Пять основных этапов в работе с данными

Сбор. Поиск каналов, где можно собирать данные, и выбор методов их получения.

Проверка. Валидация, нивелирование аномалий, которые не влияют на результат и мешают дальнейшему анализу.

Анализ. Изучение данных, подтверждение предположений.

Визуализация. Представление информации в понятном для восприятия виде: графики, диаграммы.

Реакция. Принятие решений на основе данных. Например, изменение маркетинговой стратегии, увеличение бюджета компании.

Руководитель направления «Аналитика и Data Science» в Нетологии

Data

Scientist

Образование. Шесть шагов на пути к Data Scientist

Путь к этой профессии труден: невозможно овладеть всеми инструментами за месяц или даже год. Придётся постоянно учиться, делать маленькие шаги каждый день, ошибаться и пытаться вновь.

Шаг 1. Статистика, математика, линейная алгебра

Для серьезного понимания Data Science понадобится фундаментальный курс по теории вероятностей (математический анализ как необходимый инструмент в теории вероятностей), линейной алгебре и математической статистике.

Фундаментальные математические знания важны, чтобы анализировать результаты применения алгоритмов обработки данных. Сильные инженеры в машинном обучении без такого образования есть, но это скорее исключение.

Что почитать

«Элементы статистического обучения», Тревор Хасти, Роберт Тибширани и Джером Фридман — если после учебы в университете осталось много пробелов. Классические разделы машинного обучения представлены в терминах математической статистики со строгими математическими вычислениями.

«Глубокое обучение», Ян Гудфеллоу. Лучшая книга о математических принципах, лежащих в основе нейронных сетей.

«Нейронные сети и глубокое обучение», Майкл Нильсен. Для знакомства с основными принципами.

Полное руководство по математике и статистике для Data Science. Крутое и нескучное пошаговое руководство, которое поможет сориентироваться в математике и статистике.

Введение в статистику для Data Science поможет понять центральную предельную теорему. Оно охватывает генеральные совокупности, выборки и их распределение, содержит полезные видеоматериалы.

Полное руководство для начинающих по линейной алгебре для специалистов по анализу данных. Всё, что необходимо знать о линейной алгебре.

Линейная алгебра для Data Scientists. Интересная статья, знакомящая с основами линейной алгебры.

Шаг 2. Программирование

Большим преимуществом будет знакомство с основами программирования. Вы можете немного упростить себе задачу: начните изучать один язык и сосредоточьтесь на всех нюансах его синтаксиса.

При выборе языка обратите внимание на Python. Во-первых, он идеален для новичков, его синтаксис относительно прост. Во-вторых, Python многофункционален и востребован на рынке труда.

Что почитать

«Автоматизация рутинных задач с помощью Python: практическое руководство для начинающих». Практическое руководство для тех, кто учится с нуля. Достаточно прочесть главу «Манипулирование строками» и выполнить практические задания из нее.

Codecademy — здесь вы научитесь хорошему общему синтаксису.

Легкий способ выучить Python 3 — блестящий мануал, в котором объясняются основы.

Dataquest поможет освоить синтаксис.

После того, как изучите основы Python, познакомьтесь с основными библиотеками:

Машинное обучение и глубокое обучение:

Обработка естественного языка:

Web scraping (Работа с web):

Python

для анализа данных

Шаг 3. Машинное обучение

Компьютеры обучаются действовать самостоятельно, нам больше не нужно писать подробные инструкции для выполнения определённых задач. Поэтому машинное обучение имеет большое значение для практически любой области, но прежде всего будет хорошо работать там, где есть Data Science.

Первый шаг в изучении машинного обучения — знакомство с тремя его основными формами.

1) Обучение с учителем — наиболее развитая форма машинного обучения. Идея в том, чтобы на основе исторических данных, для которых нам известны «правильные» значения (целевые метки), построить функцию, предсказывающую целевые метки для новых данных. Исторические данные промаркированы. Маркировка (отнесение к какому-либо классу) означает, что у вас есть особое выходное значение для каждой строки данных. В этом и заключается суть алгоритма.

2) Обучение без учителя. У нас нет промаркированных переменных, а есть много необработанных данных. Это позволяет идентифицировать то, что называется закономерностями в исторических входных данных, а также сделать интересные выводы из общей перспективы. Итак, выходные данные здесь отсутствуют, есть только шаблон, видимый в неконтролируемом наборе входных данных. Прелесть обучения без учителя в том, что оно поддается многочисленным комбинациям шаблонов, поэтому такие алгоритмы сложнее.

3) Обучение с подкреплением применяется, когда у вас есть алгоритм с примерами, в которых отсутствует маркировка, как при неконтролируемом обучении. Однако вы можете дополнить пример положительными или отрицательными откликами в соответствии с решениями, предлагаемыми алгоритмом. Обучение с подкреплением связано с приложениями, для которых алгоритм должен принимать решения, имеющие последствия. Это похоже на обучение методом проб и ошибок. Интересный пример обучения с подкреплением — когда компьютеры учатся самостоятельно играть в видеоигры.

Что почитать

Визуализация в машинном обучении. Отличная визуализация, которая поможет понять, как используется машинное обучение.

Шаг 4. Data Mining (анализ данных) и визуализация данных

Data Mining — важный исследовательский процесс. Он включает анализ скрытых моделей данных в соответствии с различными вариантами перевода в полезную информацию, которая собирается и формируется в хранилищах данных для облегчения принятия деловых решений, призванных сократить расходы и увеличить доход.

Что почитать и посмотреть

Как работает анализ данных. Отличное видео с доходчивым объяснением анализа данных.

«Работа уборщика данных — главное препятствие для анализа» — интересная статья, в которой подробно рассматривается важность анализа данных в области Data Science.

Шаг 5. Практический опыт

Заниматься исключительно теорией не очень интересно, важно попробовать свои силы на практике. Вот несколько хороших вариантов для этого.

Используйте Kaggle. Здесь проходят соревнования по анализу данных. Существует большое количество открытых массивов данных, которые можно анализировать и публиковать свои результаты. Кроме того, вы можете смотреть скрипты, опубликованные другими участниками и учиться на успешном опыте.

Шаг 6. Подтверждение квалификации

После того, как вы изучите всё, что необходимо для анализа данных, и попробуете свои силы в открытых соревнованиях, начинайте искать работу. Преимуществом станет независимое подтверждение вашей квалификации.

Последний совет: не будьте копией копий, найдите свой путь. Любой может стать Data Scientist. В том числе самостоятельно. В свободном доступе есть всё необходимое: онлайн-курсы, книги, соревнования для практики.

Но не стоит приходить в сферу только из-за моды. Что мы слышим о Data Science: это круто, это самая привлекательная работа XXI века. Если это основной стимул для вас, его вряд ли хватит надолго. Чтобы добиться успеха, важно получать удовольствие от процесса.

А модель данных (или модель данных) [1] [2] [3] [4] [5] является абстрактная модель который организует элементы данные и стандартизирует то, как они соотносятся друг с другом и со свойствами объектов реального мира. Например, модель данных может определять, что элемент данных, представляющий автомобиль, состоит из ряда других элементов, которые, в свою очередь, представляют цвет и размер автомобиля и определяют его владельца.

Период, термин модель данных может относиться к двум различным, но тесно связанным понятиям. Иногда это относится к абстрактной формализации объектов и отношений, обнаруженных в определенной области приложения: например, клиентов, продуктов и заказов, найденных в производственной организации. В других случаях это относится к набору концепций, используемых при определении таких формализаций: например, такие концепции, как сущности, атрибуты, отношения или таблицы. Таким образом, «модель данных» банковского приложения может быть определена с использованием «модели данных» сущность-связь. В этой статье термин используется в обоих смыслах.

Модель данных явно определяет структуру данных. Модели данных обычно задаются специалистом по данным, библиотекарем данных или ученым в области цифровых гуманитарных наук в моделирование данных обозначение. Эти обозначения часто представлены в графической форме. [7]

Модель данных иногда можно назвать структура данных, особенно в контексте языки программирования. Модели данных часто дополняются функциональные модели, особенно в контексте модели предприятия.

Содержание

Обзор

Управление большим количеством структурированных и неструктурированные данные является основной функцией информационные системы. Модели данных описывают структуру, манипуляции и аспекты целостности данных, хранящихся в системах управления данными, таких как реляционные базы данных. Обычно они не описывают неструктурированные данные, такие как обработка текста документы, сообщения электронной почты, изображения, цифровое аудио и видео.

Роль моделей данных

Модель данных явно определяет структуру данных. Типичные применения моделей данных включают модели баз данных, проектирование информационных систем и обеспечение обмена данными. Обычно модели данных задаются на языке моделирования данных. [3]

Три перспективы

Значение этого подхода, согласно ANSI, состоит в том, что он позволяет трем перспективам быть относительно независимыми друг от друга. Технология хранения может измениться, не затрагивая ни логическую, ни концептуальную модель. Структура таблицы / столбца может изменяться без (обязательно) влияния на концептуальную модель. В каждом случае, конечно, структуры должны оставаться совместимыми с другой моделью. Структура таблицы / столбца может отличаться от прямого преобразования классов и атрибутов сущностей, но в конечном итоге она должна соответствовать целям структуры классов концептуальных сущностей. На ранних этапах многих проектов разработки программного обеспечения особое внимание уделяется дизайну концептуальная модель данных. Такой дизайн можно детализировать в логическая модель данных. На более поздних этапах эта модель может быть переведена на физическая модель данных. Однако также возможно реализовать концептуальную модель напрямую.

История

Одна из самых ранних новаторских работ в области моделирования информационных систем была сделана Янгом и Кентом (1958), [10] [11] который выступал за «точный и абстрактный способ определения информационных и временных характеристик обработка данных проблема «. Они хотели создать» обозначение, которое должно позволить аналитик организовать проблему вокруг любой части оборудование». Их работа была первой попыткой создать абстрактную спецификацию и инвариантную основу для проектирования различных альтернативных реализаций с использованием различных аппаратных компонентов. Следующий шаг в моделировании ИБ был сделан КОДАСИЛ, консорциум ИТ-индустрии, образованный в 1959 году, который, по сути, преследовал то же самое, что и Янг и Кент: разработка «надлежащей структуры для машинно-независимого языка определения проблем на системном уровне обработки данных». Это привело к разработке конкретной ИС. информационная алгебра. [11]

В 1960-х годах моделирование данных приобрело большее значение с появлением Информационная система управления (MIS) концепция. По словам Леондеса (2002), «в это время информационная система предоставляла данные и информацию для целей управления. Первое поколение система базы данных, называется Интегрированное хранилище данных (IDS), был разработан Чарльз Бахман в General Electric. Две известные модели баз данных, сетевая модель данных и иерархическая модель данных, были предложены в этот период ». [12] К концу 1960-х гг. Эдгар Ф. Кодд разработал свои теории организации данных и предложил реляционная модель для управления базами данных на основе логика предикатов первого порядка. [13]

В 1970-е годы моделирование отношений сущностей возник как новый тип концептуального моделирования данных, первоначально предложенный в 1976 г. Питер Чен. Модели сущностей-отношений использовались на первом этапе информационная система дизайн во время анализ требований описать информационные потребности или тип Информация который должен храниться в база данных. Этой техникой можно описать любой онтология, т.е. обзор и классификация понятий и их взаимосвязей, для определенного сфера интересов.

В 1970-е годы Г. Nijssen разработал метод анализа информации на естественном языке (NIAM), который был разработан в 1980-х годах в сотрудничестве с Терри Хэлпин в Объектно-ролевое моделирование (ORM). Однако именно докторская диссертация Терри Халпина в 1989 году создала формальную основу, на которой основано объектно-ролевое моделирование.

Билл Кент в своей книге 1978 года Данные и реальность, [14] сравнил модель данных с картой территории, подчеркнув, что в реальном мире «автомагистрали не окрашены в красный цвет, у рек нет линий графства, проходящих посередине, и вы не можете увидеть контурные линии на горе». В отличие от других исследователей, которые пытались создать математически чистые и элегантные модели, Кент подчеркивал существенную беспорядок в реальном мире и задачу разработчика моделей данных создавать порядок из хаоса, не искажая истину.

В 1980-х годах, согласно Яну Л. Харрингтону (2000), «развитие объектно-ориентированный парадигма привела к фундаментальному изменению нашего взгляда на данные и процедур, которые работают с данными. Традиционно данные и процедуры хранятся отдельно: данные и их взаимосвязь в базе данных, процедуры в прикладной программе. Однако объектная ориентация объединила процедуру сущности с ее данными ». [15]

Модель базы данных

Было предложено несколько таких моделей. Общие модели включают:

Моделирование данных: обзор

В работе мы с коллегами часто видим как компании сталкиваются с проблемой управления данными – когда таблиц и запросов становится сильно много и управлять всем этим очень сложно. В таких ситуациях мы рекомендуем моделировать данные. Чтобы разобраться, что это такое – я перевела статью-обзор про моделирование данных от Towards Data Science, в которой кроме основных терминов и понятий можно найти наглядный пример использования моделирования данных в ритейле. Вперед под кат!

Если вы посмотрите на любое программное приложение, то увидите, что на фундаментальном уровне оно занимается организацией, обработкой и представлением данных для выполнения бизнес-требований.

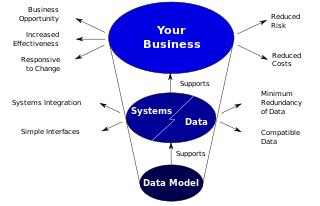

Модель данных — это концептуальное представление для выражения и передачи бизнес-требований. Она наглядно показывает характер данных, бизнес-правила, управляющие данными, и то, как данные будут организованы в базе данных.

Моделирование данных можно сравнить со строительством дома. Допустим, компании ABC необходимо построить дом для гостей (база данных). Компания вызывает архитектора (разработчик моделей данных) и объясняет требования к зданию (бизнес-требования). Архитектор (модельер данных) разрабатывает план (модель данных) и передает его компании ABC. Наконец, компания ABC вызывает инженеров-строителей (администраторов баз данных и разработчиков баз данных) для строительства дома.

Ключевые термины в моделировании данных

Сущности и атрибуты. Сущности — это «вещи» в бизнес-среде, о которых мы хотим хранить данные, например, продукты, клиенты, заказы и т.д. Атрибуты используются для организации и структурирования данных. Например, нам необходимо хранить определенную информацию о продаваемых нами продуктах, такую как отпускная цена или доступное количество. Эти фрагменты данных являются атрибутами сущности Product. Сущности обычно представляют собой таблицы базы данных, а атрибуты — столбцы этих таблиц.

Взаимосвязь. Взаимосвязь между сущностями описывает, как одна сущность связана с другой. В модели данных сущности могут быть связаны как: «один к одному», «многие к одному» или «многие ко многим».

Сущность пересечения. Если между сущностями есть связь типа «многие ко многим», то можно использовать сущность пересечения, чтобы декомпозировать эту связь и привести ее к типу «многие к одному» и «один ко многим».

Простой пример: есть 2 сущности — телешоу и человек. Каждое телешоу может смотреть один или несколько человек, в то время как человек может смотреть одно или несколько телешоу.

Эту проблему можно решить, введя новую пересекающуюся сущность «Просмотр записи»:

ER диаграмма показывает сущности и отношения между ними. ER-диаграмма может принимать форму концептуальной модели данных, логической модели данных или физической модели данных.

Концептуальная модель данных включает в себя все основные сущности и связи, не содержит подробных сведений об атрибутах и часто используется на начальном этапе планирования. Пример:

Логическая модель данных — это расширение концептуальной модели данных. Она включает в себя все сущности, атрибуты, ключи и взаимосвязи, которые представляют бизнес-информацию и определяют бизнес-правила. Пример:

Физическая модель данных включает в себя все необходимые таблицы, столбцы, связи, свойства базы данных для физической реализации баз данных. Производительность базы данных, стратегия индексации, физическое хранилище и денормализация — важные параметры физической модели. Пример:

Основные этапы моделирования данных:

Реляционное vs размерное моделирование

В зависимости от бизнес-требований ваша модель данных может быть реляционной или размерной. Реляционная модель — это метод проектирования, направленный на устранение избыточности данных. Данные делятся на множество дискретных сущностей, каждая из которых становится таблицей в реляционной базе данных. Таблицы обычно нормализованы до 3-й нормальной формы. В OLTP приложениях используется эта методология.

В размерной модели данные денормализованы для повышения производительности. Здесь данные разделены на измерения и факты и упорядочены таким образом, чтобы пользователю было легче извлекать информацию и создавать отчеты.

Компания ABC имеет 200 продуктовых магазинов в восьми городах. В каждом магазине есть разные отделы, такие как «Товары повседневного спроса», «Косметика», «Замороженные продукты», «Молочные продукты» и т.д. В каждом магазине на полках находится около 20 000 отдельных товаров. Отдельные продукты называются складскими единицами (SKU). Около 6 000 артикулов поступают от сторонних производителей и имеют штрих-коды, нанесенные на упаковку продукта. Эти штрих-коды называются универсальными кодами продукта (UPC). Данные собираются POS-системой в 2 местах: у входной двери для покупателей, и у задней двери, где поставщики осуществляют доставку.

В продуктовом магазине менеджмент занимается логистикой заказа, хранением и продажами продуктов. Также продолжают расти рекламные активности, такие как временные скидки, реклама в газетах и т.д.

Разработайте модель данных для анализа операций этой продуктовой сети.

Решение

Шаг 1. Сбор бизнес-требований

Руководство хочет лучше понимать покупки клиентов, фиксируемые POS-системой. Модель должна позволять анализировать, какие товары продаются, в каких магазинах, в какие дни и по каким акционным условиям. Кроме того, это складская среда, поэтому необходима размерная модель.

Шаг 2: Идентификация сущностей

В случае размерной модели нам необходимо идентифицировать наши факты и измерения. Перед разработкой модели необходимо уточнить объем требуемых данных. Согласно требованию, нам нужно видеть данные о конкретном продукте в определенном магазине в определенный день по определенной схеме продвижения. Это дает нам представление о необходимых сущностях:

Количество, которое необходимо рассчитать (например, объем продаж, прибыль и т.д), будет отражено в таблице с фактическими продажами.

Шаг 3: Концептуальная модель данных

Предварительная модель данных будет создана на основе информации, собранной о сущностях. В нашем случае она будет выглядеть так:

Шаг 4: Доработка атрибутов и создание логической модели данных

Теперь необходимо завершить работу над атрибутами для сущностей. В нашем случае дорабатываются следующие атрибуты:

Date Dimension:

Product:

Store:

Promotion:

Sales Fact:

Объем продаж (например, количество банок овощного супа с лапшой).

Сумма продаж в долларах: количество продаж * цена за единицу.

Стоимость в долларах: стоимость продукта, взимаемая поставщиком.

Логическая модель данных будет выглядеть так:

Шаг 5: Создание физических таблиц в базе данных

С помощью инструмента моделирования данных или с помощью кастомных скриптов теперь можно создавать физические таблицы в базе данных.

Думаю, теперь стало достаточно очевидно, что моделирование данных — одна из важнейших задач при разработке программного приложения. И оно закладывает основу для организации, хранения, извлечения и представления данных.